मेरी रोबोटिक्स अनुसंधान अध्याय

Table of Contents

यह पोस्ट मेरी रोबोटिक्स यात्रा का वर्णन करती है, जो 2015 में FRC में रोबोटिक्स के प्रति मेरे जुनून की खोज से शुरू होती है, हाई स्कूल में और फरवरी 2021 से सितंबर 2021 तक कोलोराडो स्कूल ऑफ माइनस के ह्यूमन सेंटर्ड रोबोटिक्स (HCR) लैब में अनुसंधान सहायक के रूप में मेरे समय तक। ध्यान दें कि 2022 के अंत से, HCR लैब कोलोराडो स्कूल ऑफ माइनस से यूनिवर्सिटी ऑफ मैसाचुसेट्स अम्हर्स्ट में स्थानांतरित हो गई है, साथ ही इसकी साइट hcr.mines.edu से hcr.cs.umass.edu में।

पृष्ठभूमि

मैंने कोलोराडो स्कूल ऑफ माइनस में फॉल 2018 सेमेस्टर में अपनी स्नातक की पढ़ाई शुरू की। मेरा प्रमुख कंप्यूटर विज्ञान था जिसमें रोबोटिक्स और इंटेलिजेंट सिस्टम पर ध्यान केंद्रित किया गया था। और मैंने स्प्रिंग 2022 में स्नातक किया।

मैं अपने जीवन में जल्दी ही अपने जुनून को खोजने के लिए भाग्यशाली था। हाई स्कूल के दौरान, मैंने यह पता लगाने के लिए अच्छा समय बिताया कि मुझे क्या पसंद है और मैं किसमें अच्छा कर सकता हूँ। कुछ प्रयास और त्रुटियों के बाद, मैं यह पता लगाने में सक्षम था कि मेरा जुनून कंप्यूटर विज्ञान था। लेकिन इसी समय मैंने यह भी खोजा कि मुझे कोड के माध्यम से निर्माण करने का अत्यधिक प्यार है।

माइनस में, मुझे डॉ. हाओ झांग के तहत माइनस के ह्यूमन सेंटर्ड रोबोटिक्स (HCR) लैब में काम करने का अवसर मिला। मैंने पहली बार डॉ. झांग से स्प्रिंग 2020 में उनकी कक्षा “ह्यूमन सेंटर्ड रोबोटिक्स” (CSCI473) के माध्यम से मुलाकात की, और COVID और कक्षा के काम के अराजकता के बाद, मुझे शुरुआती स्प्रिंग 2021 में उनके लैब में काम करने का मौका मिला।

ह्यूमन सेंटर्ड रोबोटिक्स (CSCI473) कक्षा

माइनस का ह्यूमन सेंटर्ड रोबोटिक्स (CSCI473) मेरी कॉलेज की अनुभव में से कुछ कक्षाओं में से एक था जिसने मुझ पर गहरा प्रभाव डाला। यह कक्षा डॉ. हाओ झांग द्वारा पढ़ाई गई थी। कक्षा के लिए हमारा पूरा ग्रेड केवल तीन परियोजनाओं से बना था, प्रत्येक ने रोबोटिक्स के मूल सिद्धांतों को पेश करने वाली चुनौतीपूर्ण समस्या प्रस्तुत की। इन परियोजनाओं में शामिल थे:

- रोबोट ऑपरेटिंग सिस्टम (ROS) सीखना

- रोबोट दीवार का पालन करने के लिए सुदृढीकरण सीखना

- मानव व्यवहारों की समझ के लिए कंकाल-आधारित प्रतिनिधित्व का उपयोग करना

रोबोट ऑपरेटिंग सिस्टम (ROS) सीखना

यह पहली परियोजना थी जिसे हमें सौंपा गया था। परियोजना में तीन कार्य शामिल थे:

- विकास वातावरण सेटअप करना

- गज़ेबो सिम्युलेटर को समझना

- एक ROS “हैलो वर्ल्ड” लिखना

कार्य 1 और 2 के लिए, हमें केवल अपने विकास वातावरण को सेटअप करना था और गज़ेबो ट्यूटोरियल का पालन करना था। इसमें शामिल था:

- ROS मेलोडिक को सेटअप करना, जिसे मैंने अपने 2011 के HP लैपटॉप पर किया जो काफी अच्छा था

- ROS और गज़ेबो को स्थापित और कॉन्फ़िगर करना

- गज़ेबो सिम के ट्यूटोरियल और ई-हैंडबुक के ट्यूटोरियल के माध्यम से जाना।

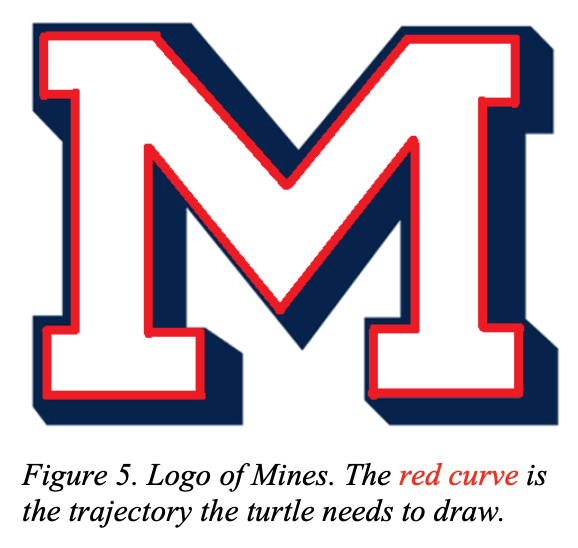

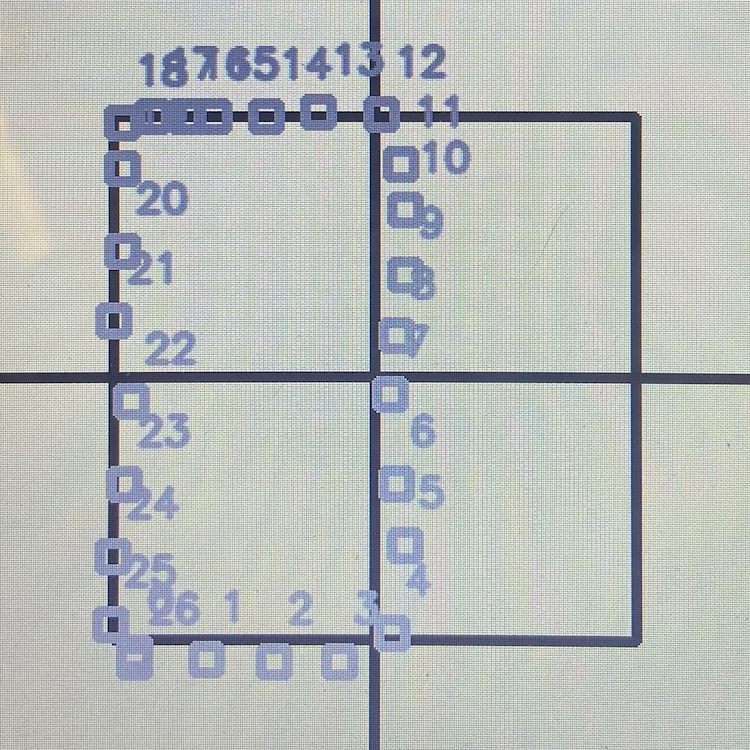

कार्य 3, दूसरी ओर, एक वास्तविक चुनौती थी। कार्य था turtlesim का उपयोग करना और कछुए को माइनस का “M” लोगो बनाना:

|

|

यह कार्य, हालांकि यह सरल लग रहा था, उतना आसान नहीं था जितना यह दिखता था। इस परियोजना ने मुझे ओपन-लूप और क्लोज़-लूप सिस्टम के सिद्धांत से परिचित कराया। पूरी परियोजना का विवरण देखने के लिए csci473-p1.pdf देखें या आप इस परियोजना और मेरे समाधान के बारे में ROS मूव टर्टल परियोजना पृष्ठ पर अधिक जान सकते हैं।

रोबोट दीवार का पालन करने के लिए सुदृढीकरण सीखना

यह दूसरी परियोजना थी जिसे हमें सौंपा गया था, और यह कॉलेज में मैंने कभी भी काम की सबसे कठिन परियोजनाओं में से एक थी। परियोजना का विवरण इस प्रकार था:

इस परियोजना में, छात्र एक स्वायत्त मोबाइल रोबोट को दीवार का पालन करने और बाधाओं से टकराने से बचाने के लिए सुदृढीकरण सीखने के एल्गोरिदम को डिजाइन और कार्यान्वित करेंगे। छात्र ROS मेलोडिक में गज़ेबो सिमुलेशन का उपयोग करके एक ऑम्नि-डायरेक्शनल मोबाइल रोबोट नामक ट्राइटन का अनुकरण करेंगे, और एक पर्यावरण मानचित्र का उपयोग करेंगे जो आपको प्रदान किया गया है। छात्रों को रोबोट पर सेंसिंग और सीखने के लिए लेजर रेंज स्कैनर का उपयोग करना होगा, जहां रोबोट को स्टीयरिंग और वेग आदेशों का उपयोग करके नियंत्रित किया जाएगा। छात्रों को इस परियोजना को C++ या Python में ROS मेलोडिक पर उबंटू 18.04 LTS (यानी, परियोजना 1 में उपयोग किए गए समान विकास वातावरण) में प्रोग्राम करने की आवश्यकता है। इसके अलावा, छात्रों को LATEX का उपयोग करके मानक IEEE रोबोटिक्स सम्मेलनों के प्रारूप का पालन करते हुए एक रिपोर्ट लिखने की आवश्यकता है।

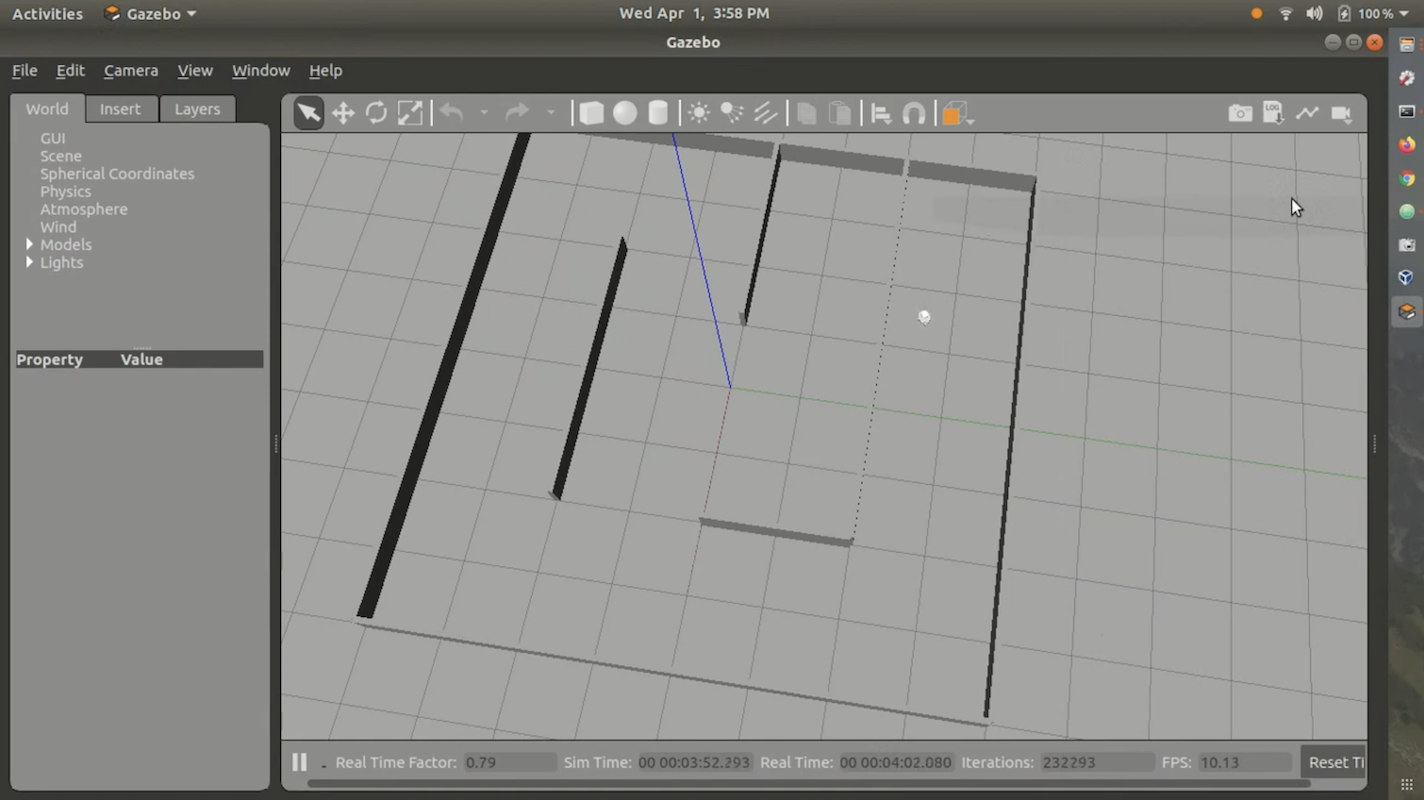

सुदृढीकरण सीखने के एल्गोरिदम के लिए, हमें Q-लर्निंग का उपयोग करने के लिए निर्देशित किया गया था। हमने कक्षा द्वारा प्रदान किए गए स्टिंगरे गज़ेबो सिमुलेशन वातावरण का भी उपयोग किया। स्टिंगरे में ट्राइटन मॉडल और भौतिक तर्क शामिल था। हमें रोबोट के लिए अनुसरण करने के लिए एक भूलभुलैया भी प्रदान की गई थी। कुल मिलाकर, वातावरण इस तरह दिखता था:

मैंने अपने समाधान को GitHub या वेब पर प्रकाशित नहीं किया क्योंकि यह बहुत अच्छा नहीं था और इसमें कई दोष थे। इसके अलावा, सही वातावरण में कोड चलाना काफी कठिन और परेशान करने वाला था। हालाँकि, मेरे पास एक डेमो वीडियो है जिसे मैंने कक्षा में प्रस्तुत किया, जो मेरे समाधान को दिखाता है। आप इसे यहाँ देख सकते हैं:

पूरी परियोजना का विवरण देखने के लिए csci473-p2.pdf देखें।

मानव व्यवहारों की समझ के लिए कंकाल-आधारित प्रतिनिधित्व का उपयोग करना

तीसरी परियोजना के लिए, परियोजना का विवरण इस प्रकार था:

इस परियोजना में, छात्र कई कंकाल आधारित प्रतिनिधित्व (डिलिवरेबल 1) को लागू करेंगे और मानव व्यवहारों को वर्गीकृत करने के लिए सपोर्ट वेक्टर मशीन (SVMs) (डिलिवरेबल 2) का उपयोग करेंगे, जो कि एक सार्वजनिक गतिविधि डेटासेट से एकत्रित किया गया है जो कि एक कनेक्ट V1 सेंसर से है। इसके अतिरिक्त, छात्रों को डिलिवरेबल 3 में LATEX का उपयोग करके मानक IEEE रोबोटिक्स सम्मेलनों के प्रारूप का पालन करते हुए एक रिपोर्ट लिखने की आवश्यकता है।

यह परियोजना चुनौतीपूर्ण थी लेकिन दूसरी परियोजना के रूप में कठिन नहीं थी। मुख्य लक्ष्य कनेक्ट V1 सेंसर डेटा का उपयोग करना था, MSR डेली एक्टिविटी 3D डेटासेट से, और सपोर्ट वेक्टर मशीन का उपयोग करके कुछ मानव क्रियाओं/व्यवहारों को वर्गीकृत करना। पूरी परियोजना का विवरण देखने के लिए csci473-p3.pdf देखें या आप इस परियोजना और मेरे समाधान के बारे में LIBSVM का उपयोग करके मानव क्रियाओं की भविष्यवाणी करें ब्लॉग पोस्ट पर अधिक जान सकते हैं।

CSCI473 निष्कर्ष

CSCI473 मेरी स्नातक की पढ़ाई के दौरान मैंने जो सबसे अच्छी कक्षाएँ लीं, उनमें से एक है, यदि सबसे अच्छी नहीं है, माइनस में। इन सभी परियोजनाओं ने मुझे बहुत कुछ सिखाया और मुझे परियोजनाओं का एक अच्छा कैटलॉग बनाने की अनुमति दी, जिस पर मैं विचार कर सकता था और अपने रिज़्यूमे पर संदर्भित कर सकता था। यह पहली कक्षा भी थी जहाँ मुझे ऐसा लगा कि मैं अपने तत्व में हूँ, क्योंकि मैं कभी भी एक अच्छा परीक्षा लेने वाला नहीं था लेकिन परियोजनाओं को पूरा करने में उत्कृष्ट था। यह भी इस कक्षा के माध्यम से था कि मैंने डॉ. हाओ झांग से मिला, जिन्होंने अंततः मुझे माइनस के ह्यूमन-सेंटर्ड रोबोटिक्स (HCR) लैब में अनुसंधान सहायक के रूप में एक पद सुरक्षित करने में मदद की।

CS फील्ड सेशन (गर्मी 2020)

गर्मी 2020 के दौरान, CSCI473 को पूरा करने और HCR लैब में शामिल होने के बीच, मैंने कोलोराडो स्कूल ऑफ माइनस में अपने CS स्नातक कार्यक्रम के हिस्से के रूप में CSCI370 या “एडवांस्ड सॉफ्टवेयर इंजीनियरिंग” लिया। CSCI370 एक पाठ्यक्रम है जो छात्रों को एक कंपनी के लिए सॉफ्टवेयर-संबंधित समाधानों को डिजाइन, कार्यान्वित और दस्तावेज़ करने के लिए बनाता है। यह छात्रों को अपने पाठ्यक्रम ज्ञान को वास्तविक दुनिया की कंप्यूटर विज्ञान की समस्याओं पर लागू करने की अनुमति देता है। आप पाठ्यक्रम के बारे में यहाँ अधिक जान सकते हैं।

इस पाठ्यक्रम में, आप यह तय करते हैं कि आप किस परियोजना/कंपनी पर काम करेंगे। पाठ्यक्रम ने प्रत्येक परियोजना और कंपनी का विवरण देने वाले PDF प्रदान किए। अंततः मैंने एक कंपनी द्वारा पोस्ट की गई परियोजना पर काम करने का निर्णय लिया जिसका नाम लूनर आउटपोस्ट है, जिसका नाम “रियल टाइम व्हील स्लिप डिटेक्शन और एरर करेक्शंस फॉर एनहांस्ड लूनर नेविगेशन” है। चूंकि नाम लंबा है, आइए परियोजना को “व्हील स्लिपेज डिटेक्शन” का उपनाम दें।

समस्या

लूनर आउटपोस्ट एक स्टार्टअप है जो स्वायत्त चंद्रमा रोवर्स बनाने की कोशिश कर रहा है। चंद्रमा पर, बहुत सारा चंद्रमा धूल है जो पहियों के फिसलने का कारण बनती है। यह आदर्श नहीं है क्योंकि पहियों का फिसलना स्वायत्त प्रणालियों को उनके वास्तविक दुनिया के स्थान का पता खोने का कारण बन सकता है। पृथ्वी पर, इसे GPS डेटा का उपयोग करके पहियों के फिसलने के कारण किसी भी ऑफसेट को सही करने के लिए हल किया जाता है। लेकिन GPS की समस्या यह है कि यह केवल 30+ नेविगेशन उपग्रहों के पृथ्वी के चारों ओर लगातार चक्कर लगाने और अद्वितीय संकेतों को प्रसारित करने के द्वारा काम करता है जो कंप्यूटरों को अपनी स्थिति की गणना करने की अनुमति देता है। लेकिन चंद्रमा पर, वर्तमान में ऐसा कोई GPS नहीं है। यह जानकर, पहियों के फिसलने का पता लगाने के लिए GPS के अलावा एक और विधि का उपयोग करना होगा। परियोजना की समस्या की अधिक विस्तृत रिपोर्ट यहाँ देखी जा सकती है।

टीम

यह परियोजना एक साधारण परियोजना नहीं थी, इसलिए इसे एक टीम में किया जाना था। टीम में कोलोराडो स्कूल ऑफ माइनस के पांच साथी छात्र शामिल थे:

यह परियोजना एक साधारण परियोजना नहीं थी, इसलिए इसे एक टीम में किया जाना था। इस टीम में मेहमत यिलमाज़ (मैं), केन ब्रूस, ब्रेडन ओ’कालाघन, लियाम विलियम्स, और केविन ग्रांट शामिल थे।

इस परियोजना के लिए हमें कुछ ROS, C++, Python, Linux, Raspberry Pi, और Arduino का ज्ञान होना आवश्यक था। हम में से अधिकांश के पास इन तकनीकों में से एक या एक से अधिक में अनुभव था लेकिन मैं ROS में अनुभव रखने वाला एकमात्र व्यक्ति था क्योंकि मैंने स्प्रिंग 2020 सेमेस्टर के दौरान अपनी ह्यूमन सेंटर्ड रोबोटिक्स (CSCI473) कक्षा में ROS का उपयोग किया था। इस कारण से, मैंने जल्दी ही सभी को ROS के बारे में और इसके लिए विकास कैसे करना है, के बारे में जानकारी दी।

चुनौतियाँ

इस परियोजना में कई चुनौतियाँ थीं। लेकिन सबसे बड़ी चुनौती जिसका हमें सामना करना पड़ा, वह थी परीक्षण के लिए वास्तविक दुनिया के रोबोट तक पहुँच न होना। इसका कारण COVID था, जिसने सब कुछ दूरस्थ बना दिया और हमें चंद्रमा के आउटपोस्ट के प्रयोगशाला/भवनों में काम करने से रोक दिया। इसके कारण, हमें सिमुलेशन का उपयोग करना पड़ा।

इसके अलावा, हमने WVU नेविगेशन लैब से कुछ शैक्षणिक अनुसंधान का अध्ययन किया ताकि यह समझ सकें कि चंद्रमा के आउटपोस्ट के उपयोग के मामले के लिए व्हील स्लिपेज समस्या को कैसे हल किया जा सकता है, जो हमारे लिए, अंडरग्रेजुएट सोफोमोर और जूनियर्स के रूप में, अपेक्षा से अधिक कठिन था।

एक और चुनौती जिसका हमें सामना करना पड़ा, वह थी इस परियोजना पर काम करने के लिए हमारे पास समय की मात्रा। CSCI370 एक महीने की कक्षा है। लेकिन समस्या स्वयं एक विशाल समस्या है जिसे कई कंपनियाँ और अकादमिक दशकों से हल/पूर्ण करने की कोशिश कर रहे हैं। इसलिए एक महीना इस मुद्दे को हल करने के लिए पर्याप्त समय नहीं है। लेकिन, इन सभी चुनौतियों के बावजूद, हमने आगे बढ़ने का प्रयास किया और सुनिश्चित किया कि हम डिलीवर करें।

निष्कर्ष

सभी अनुसंधान और विकास के माध्यम से काम करने के बाद, हमने यह निर्धारित किया कि डिजिटल रूप से उचित चंद्रमा भौतिकी का अनुकरण करना लगभग असंभव है, इसलिए वास्तव में इस एल्गोरिदम को एक सिमुलेशन में आजमाना अच्छा नहीं है और यह अंतरिक्ष और चंद्रमा में व्हील स्लिपेज पहचान में कोई महत्वपूर्ण अनुसंधान नहीं देगा। हमने निष्कर्ष निकाला कि रेत और वास्तविक हार्डवेयर, जैसे कि हस्की रोबोट, का उपयोग करके एक उचित परीक्षण वातावरण स्थापित करना इस प्रकार के अनुसंधान के लिए कहीं अधिक महत्वपूर्ण है। हमने व्हील स्लिपेज पहचान कोड को ROS नोड के रूप में काम करने के लिए अपडेट किया और यह सही ढंग से कार्य करता था और इसे परीक्षण के लिए वास्तविक हार्डवेयर में आसानी से आयात किया जा सकता था। इस परियोजना ने मुझे नेतृत्व की भूमिका निभाने, अपने साथियों को ROS विकास पर शिक्षित करने, और Python, ROS, और Gazebo के साथ अनुभव प्राप्त करने की अनुमति दी, जबकि मैंने एक जटिल समस्या का सामना किया जिसे मैंने पहले कभी नहीं देखा था। सबसे महत्वपूर्ण बात, इस अनुभव ने मेरे रोबोटिक्स के प्रति जुनून को और मजबूत किया और मुझे इस क्षेत्र में अनुसंधान करने की इच्छा को पुनः पुष्टि की, जो मेरे रोबोटिक्स यात्रा में आगे क्या आएगा, उसके लिए मंच तैयार किया।

HCR लैब में शुरुआत

CSCI473 पूरा करने के बाद, 2020 की गर्मियों में मेरा CS फील्ड सेशन, और मेरा फॉल 2020 सेमेस्टर, मैंने रोबोटिक्स में अनुसंधान करने का निर्णय लिया। मैंने CSCI473 और CS फील्ड सेशन दोनों के साथ बहुत अच्छे अनुभव किए थे कि मैंने निर्णय लिया कि मैं HCR लैब के लिए अनुसंधान करना चाहता हूँ। चूंकि मैंने पिछले वर्ष डॉ. झांग से मुलाकात की थी, मैंने जनवरी 2021 में उन्हें ईमेल करने और लैब में किसी भी अवसर के बारे में पूछने का निर्णय लिया। लगभग 2 सप्ताह के भीतर, डॉ. झांग ने रुचि व्यक्त की, मुझे अनुसंधान विकल्प प्रस्तुत किए, और मुझे लैब में एक भूमिका की पेशकश की। फिर मैंने फरवरी 2021 में लैब के लिए काम करना शुरू किया।

परिचय वीडियो

यहाँ मेरा परिचय वीडियो है जिसे मैंने HCR लैब में अपने समय के कुछ महीनों बाद रिकॉर्ड किया था। यह मई 2021 में रिकॉर्ड किया गया था और इसमें अनुसंधान को कवर किया गया है जिस पर मैं 2021 की गर्मियों में HCR लैब में ध्यान केंद्रित करूंगा:

मेरा प्रोजेक्ट

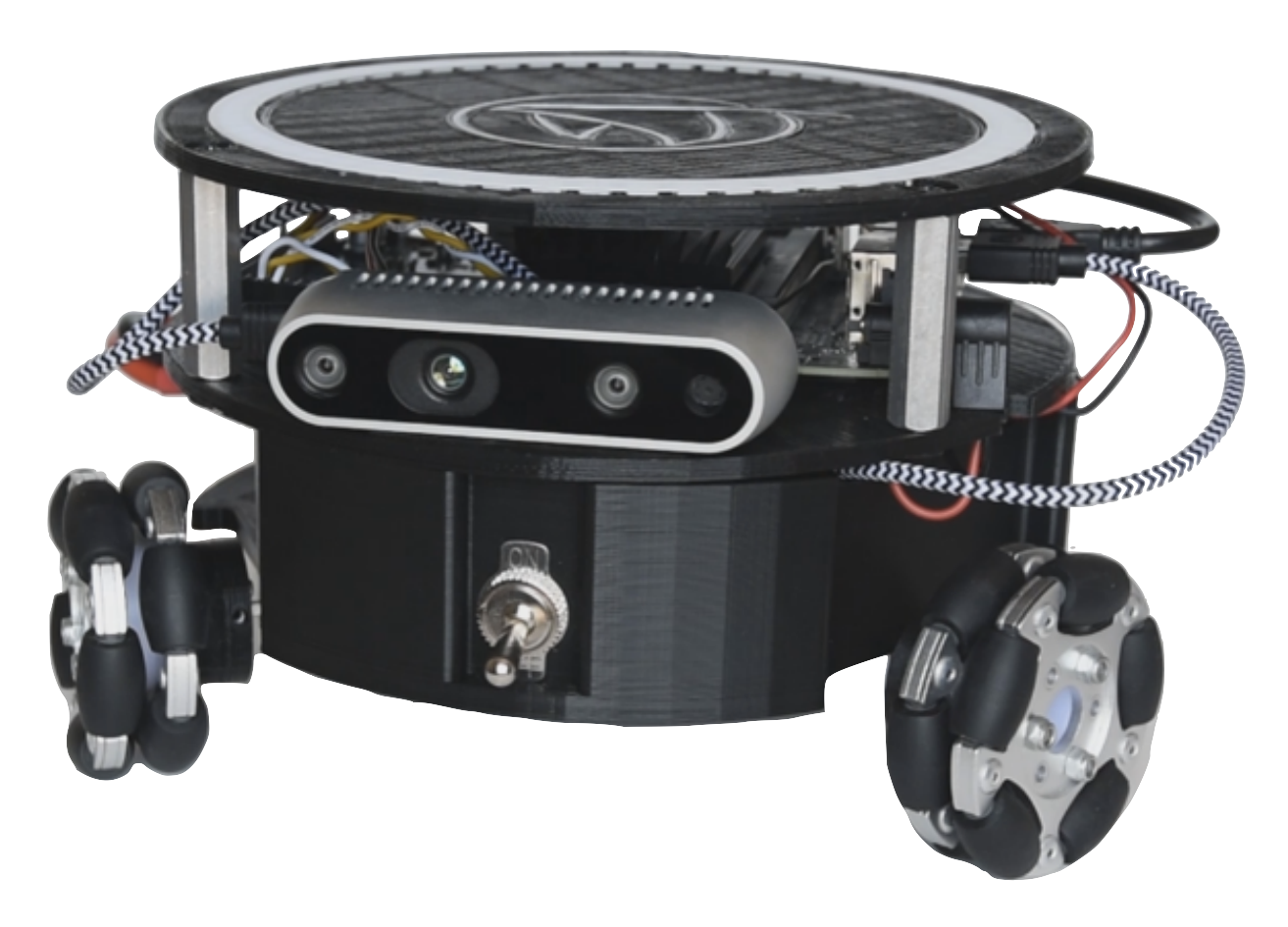

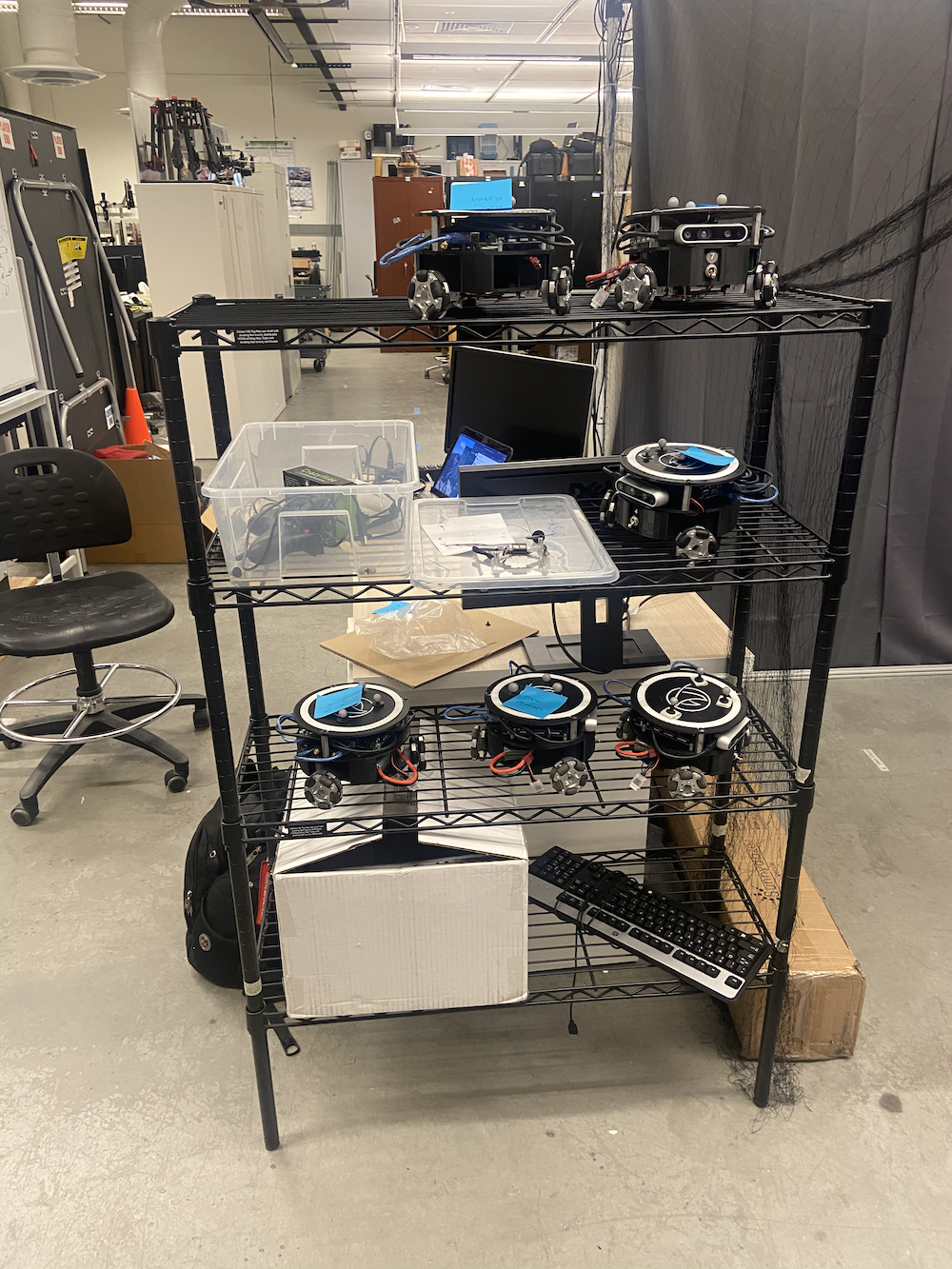

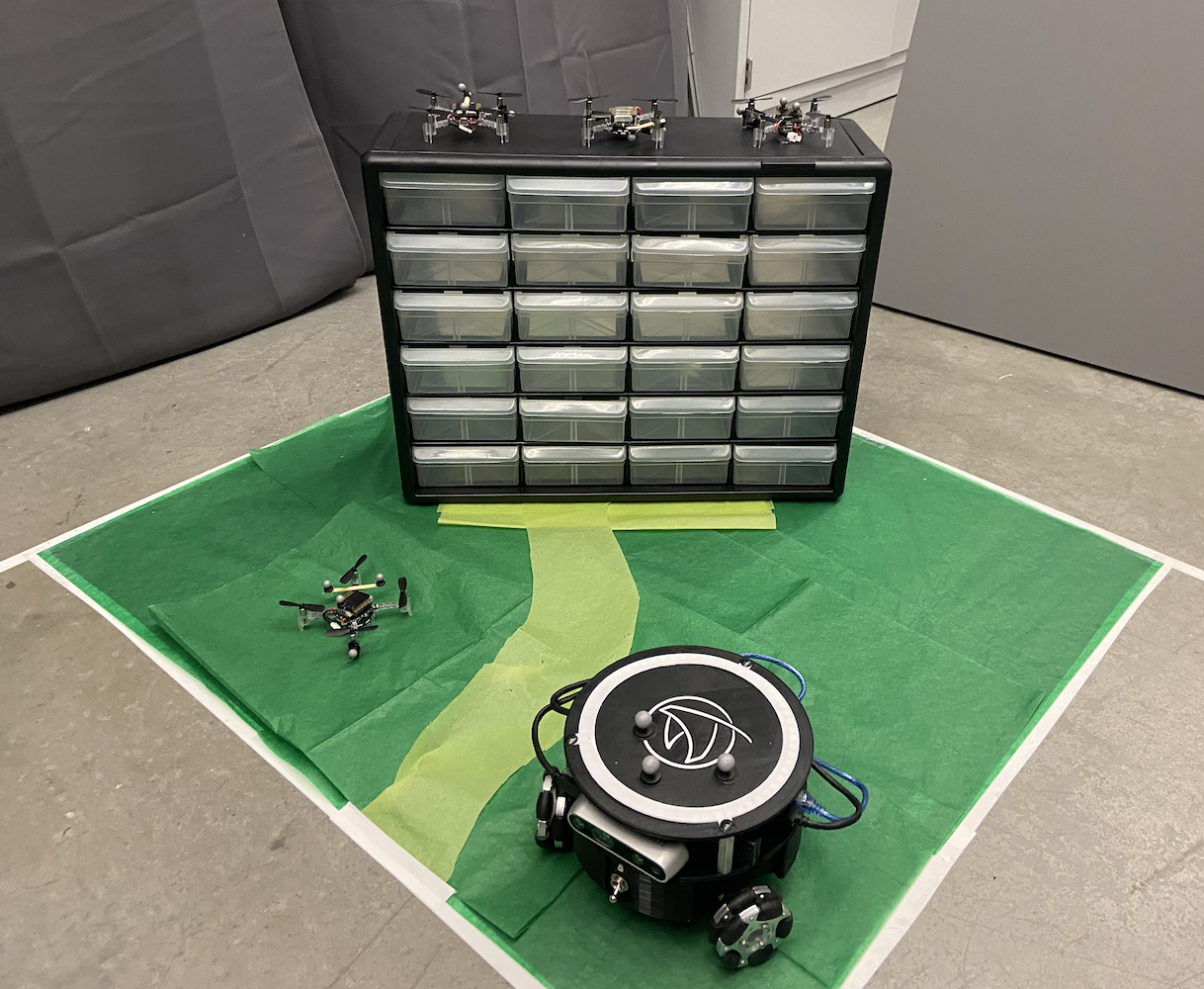

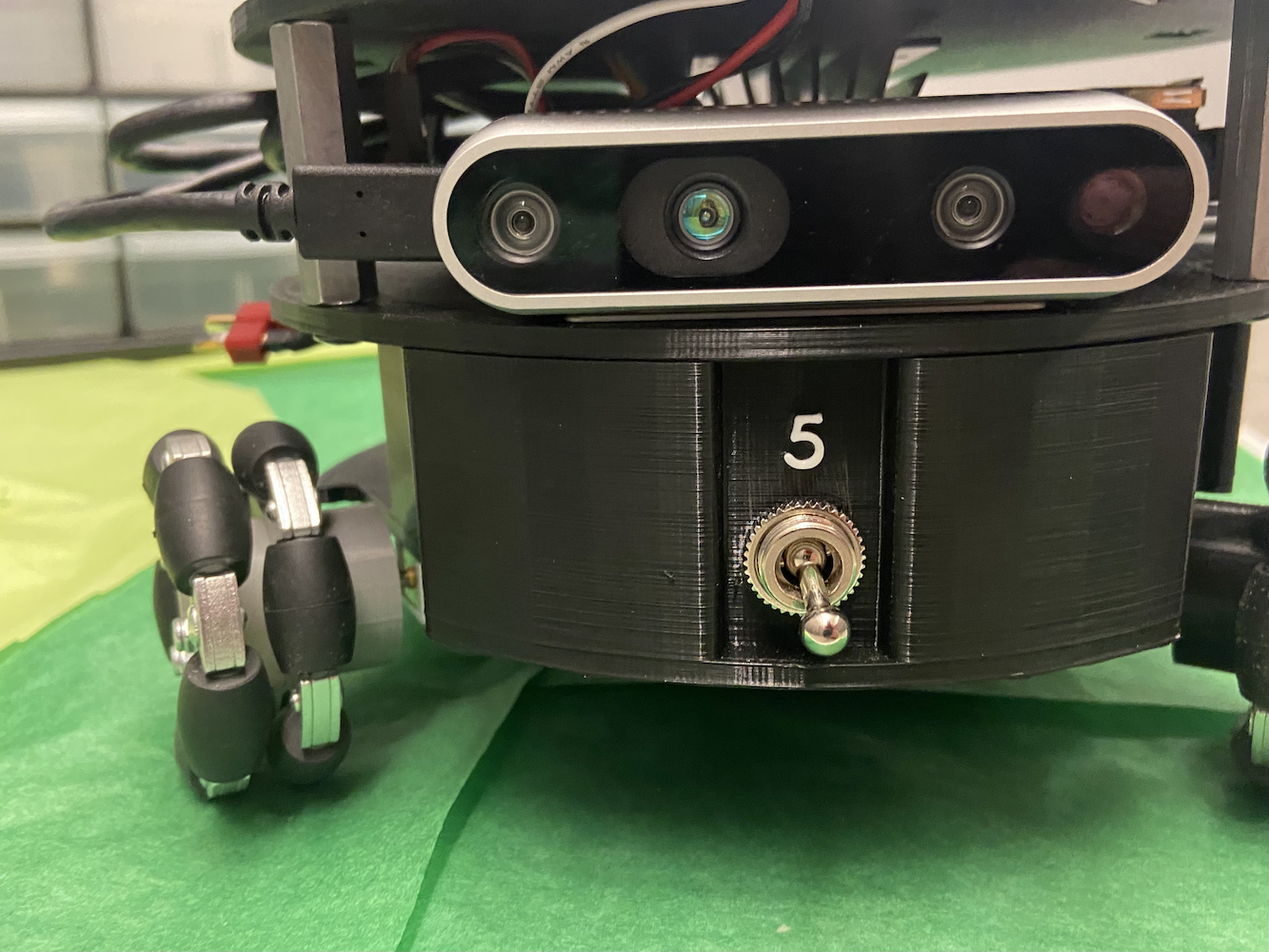

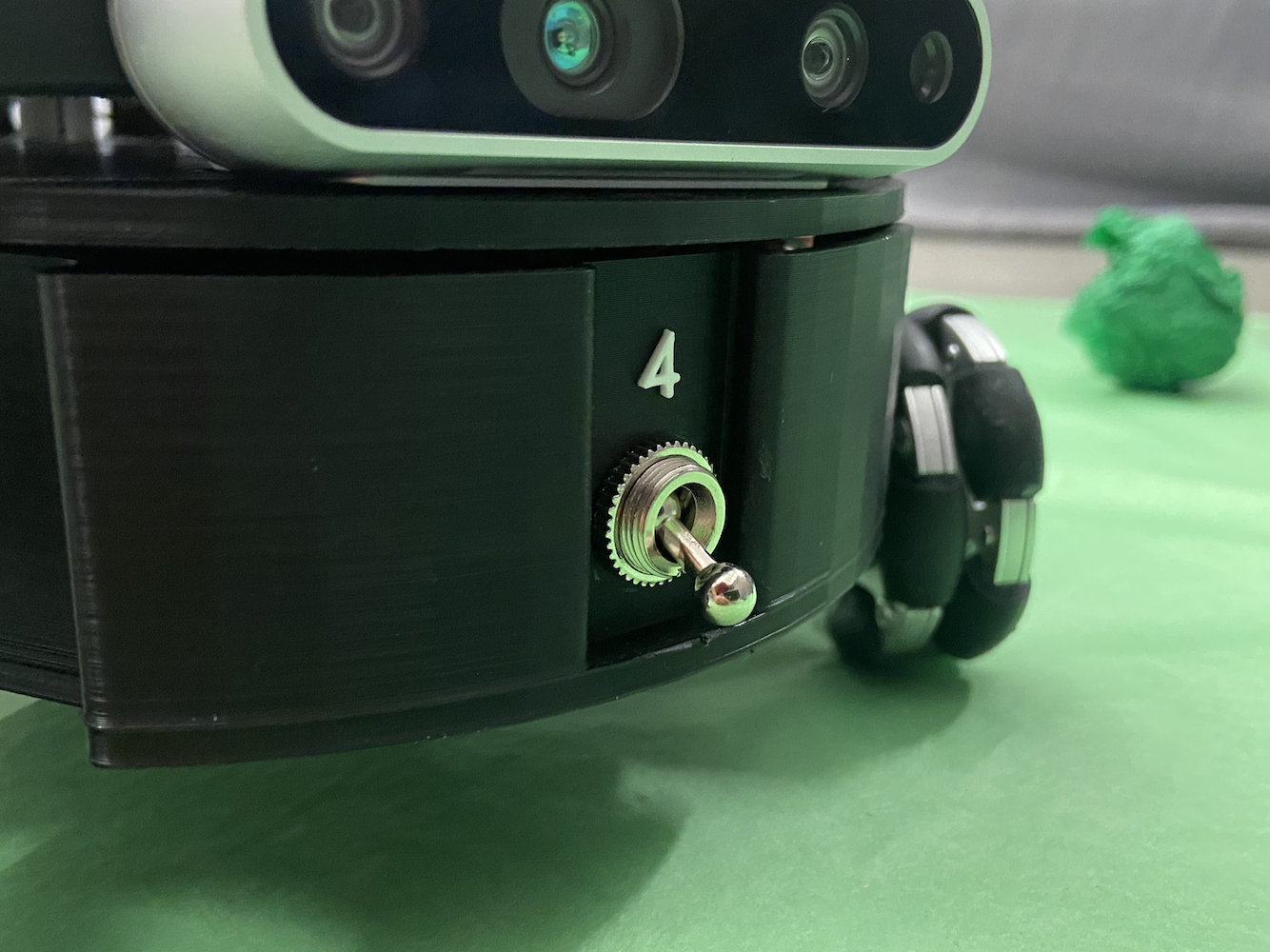

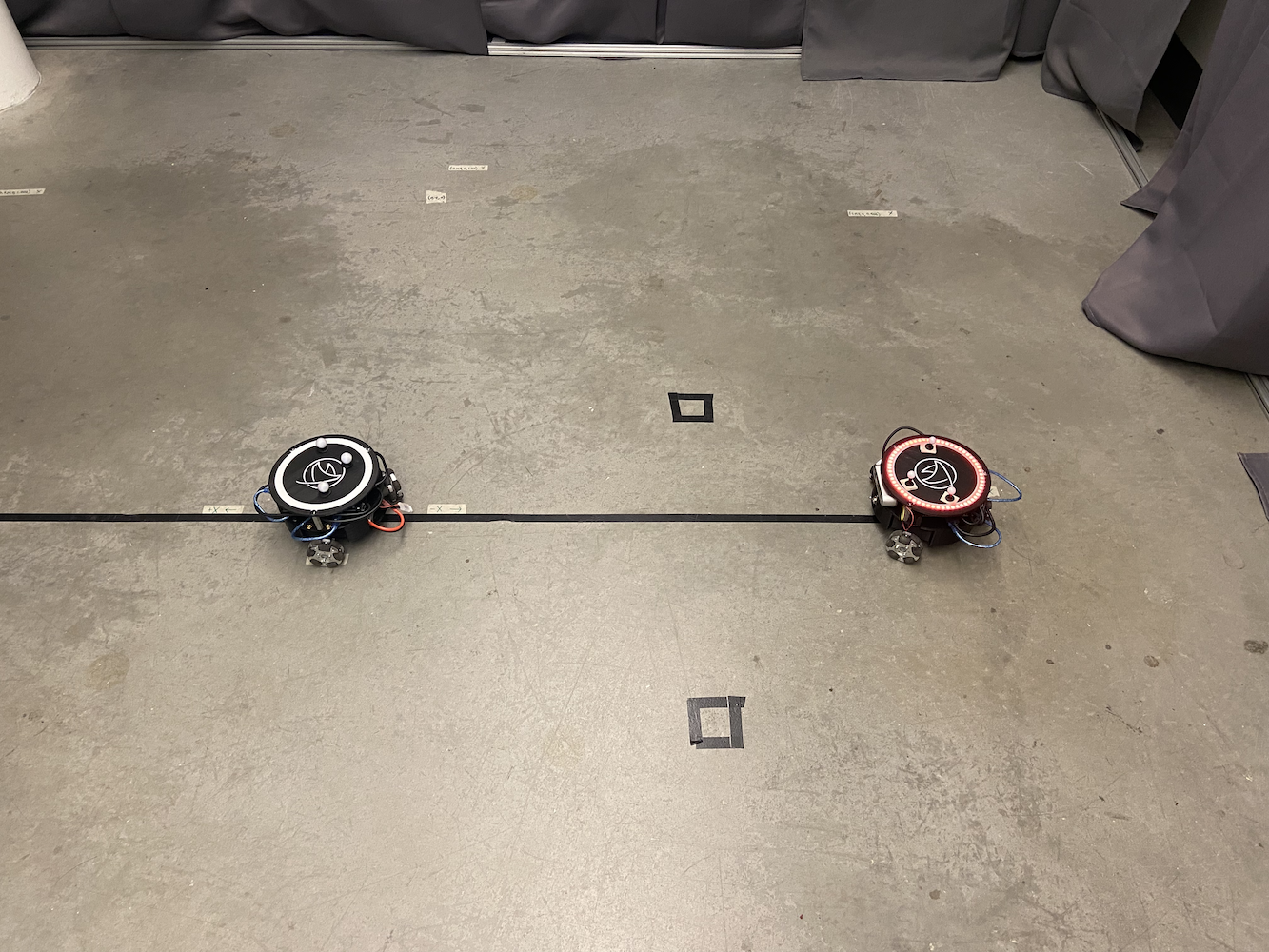

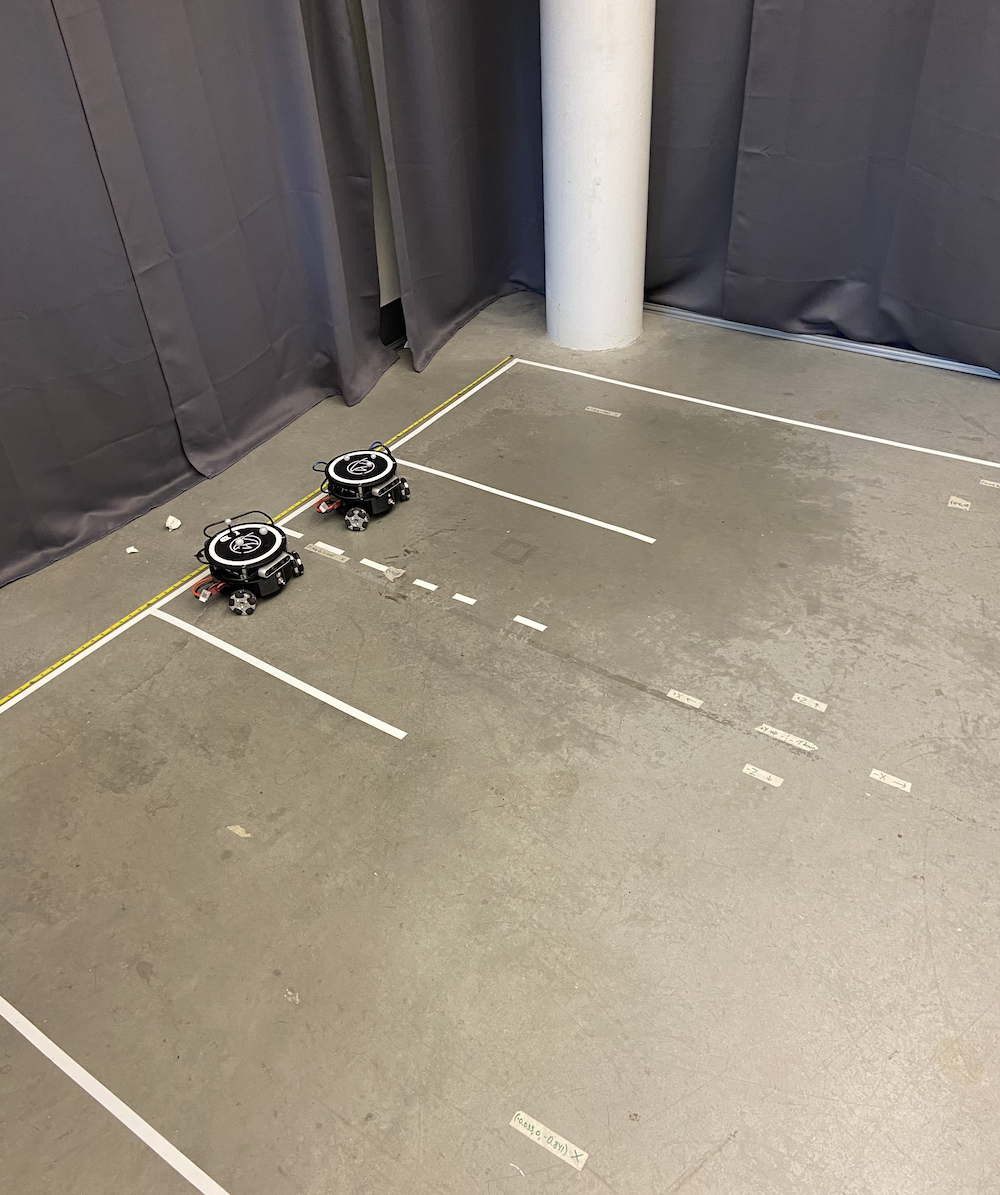

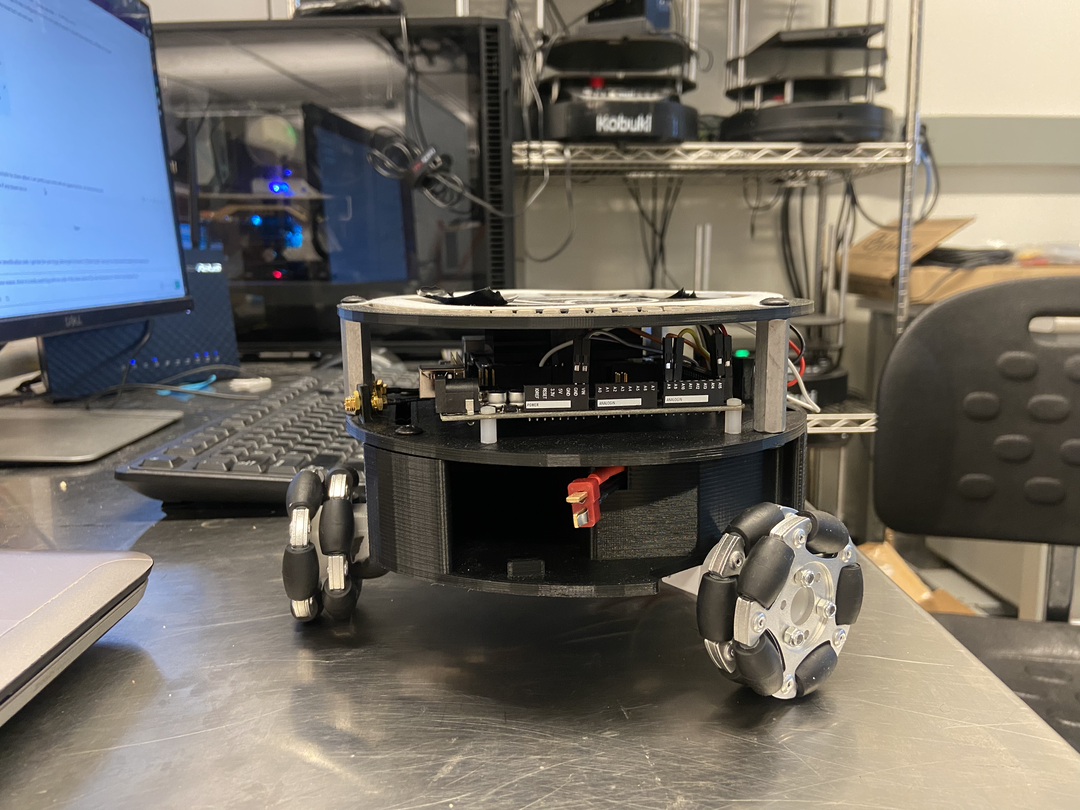

HCR लैब में अपने समय के दौरान, मैंने मुख्य रूप से Triton परियोजना पर ध्यान केंद्रित किया। Triton परियोजना एक मोबाइल रोबोट है जिसे ह्यूमन सेंटर्ड रोबोटिक्स लैब द्वारा कोलोराडो स्कूल ऑफ माइन में विकसित किया गया है। यह NVIDIA के जेटसन नैनो द्वारा संचालित एक त्रिकोणीय ओमनी-व्हील ग्राउंड रोबोट है।

Triton, एक सरल अवलोकन में, निम्नलिखित भागों से मिलकर बना था:

- NVIDIA जेटसन नैनो

- NVIDIA का सीड स्टूडियो A205 कैरियर बोर्ड

- Arduino मेगा

- 64 जीबी माइक्रो एसडी कार्ड

- कस्टम 3D प्रिंटेड बॉडी

- 3 मेकनम पहिए

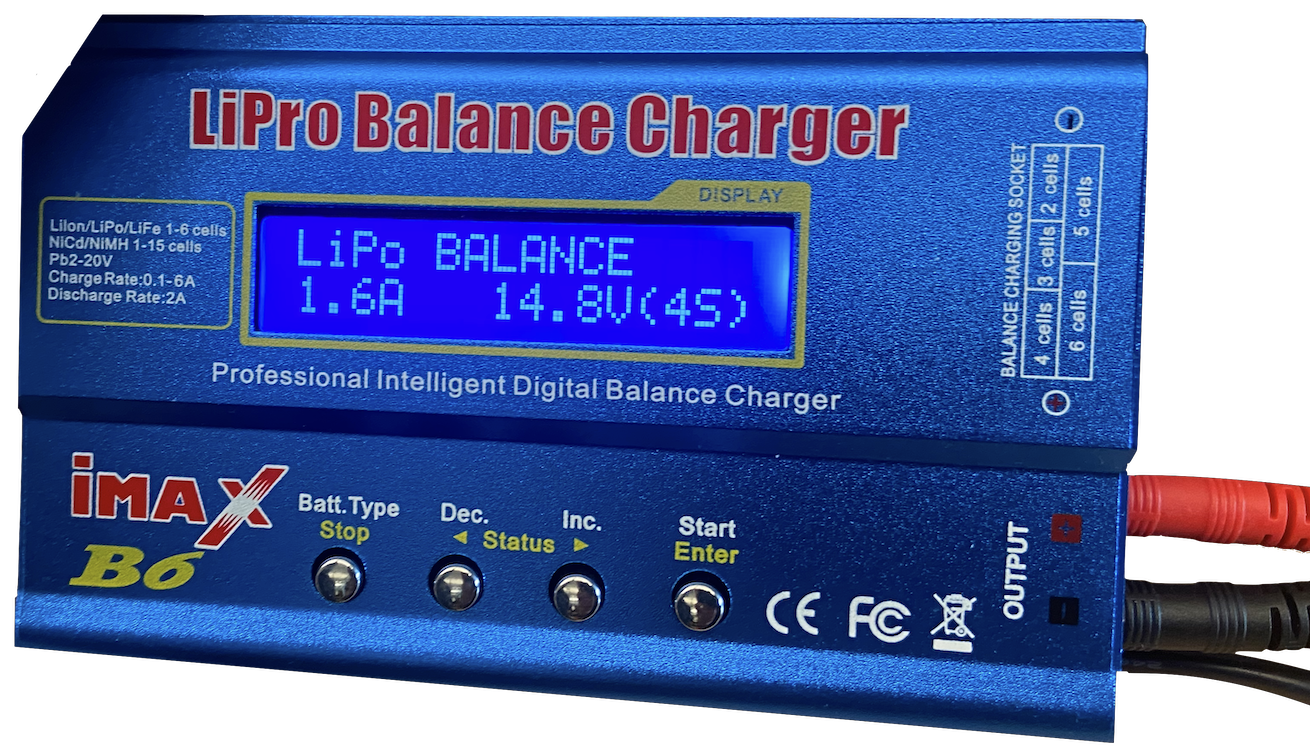

- 1 AR बैटरी

- अनुकूलित पावर वितरण और वायरिंग के लिए कस्टम सर्किट

- इंटेल का रियलसेंस D435 कैमरा

- कुछ LEDs

इसे 2018-2020 के आसपास शैक्षणिक उद्देश्यों के लिए एक रोबोट के रूप में डिज़ाइन, निर्मित और उत्पादित किया गया था। जब मैं शामिल हुआ, तब Triton काफी स्थापित था, और लैब इसके एक नए संस्करण को बनाने पर विचार कर रही थी। हालाँकि, Triton की मुख्य समस्या इसका सॉफ़्टवेयर था। Triton चल सकता था, चार्ज कर सकता था, और एक बुनियादी अर्थ में कार्य कर सकता था लेकिन वास्तव में कुछ भी बुद्धिमान नहीं कर सकता था। इसमें अधिक उन्नत आंदोलनों को करने की क्षमता भी नहीं थी।

|

|

|

|

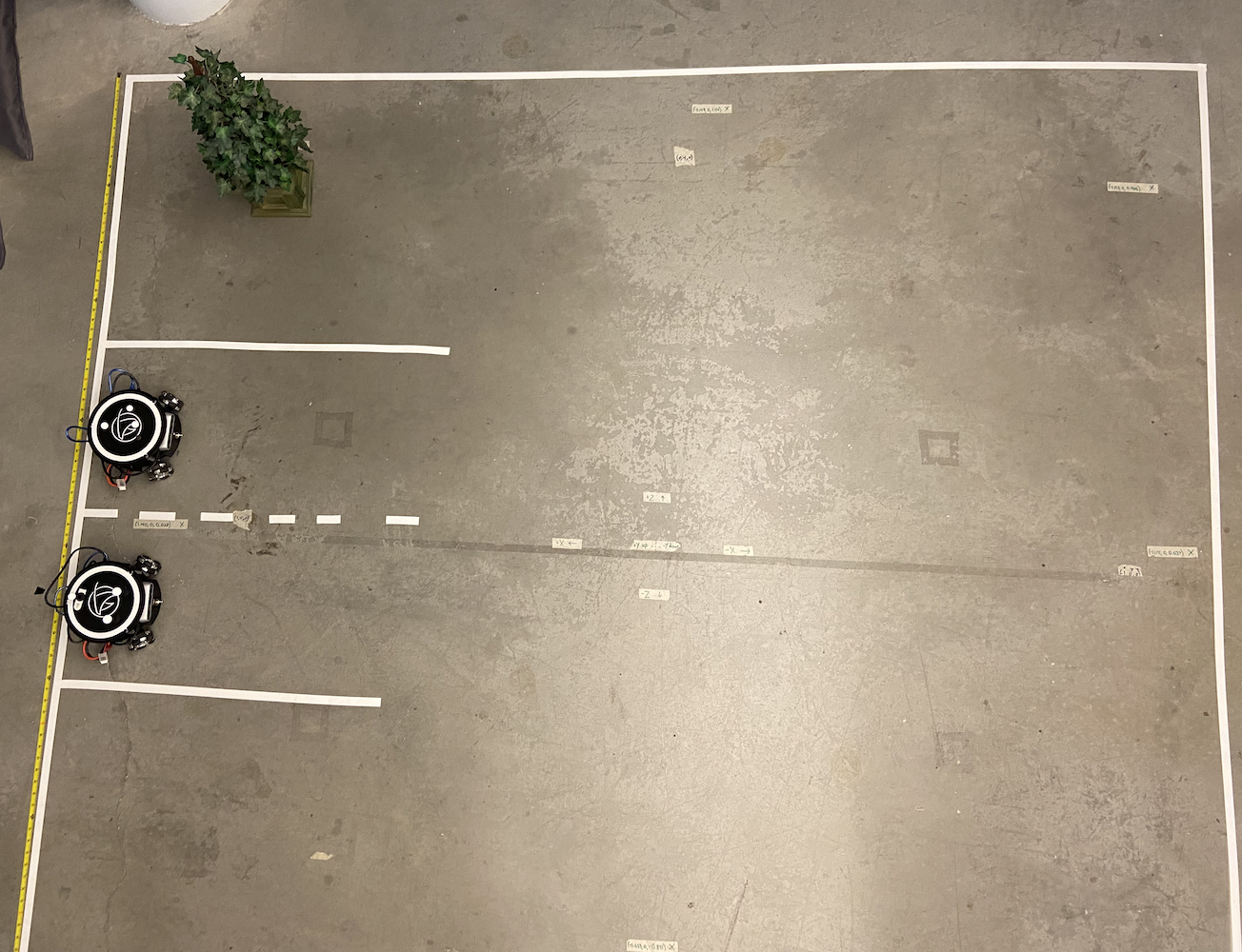

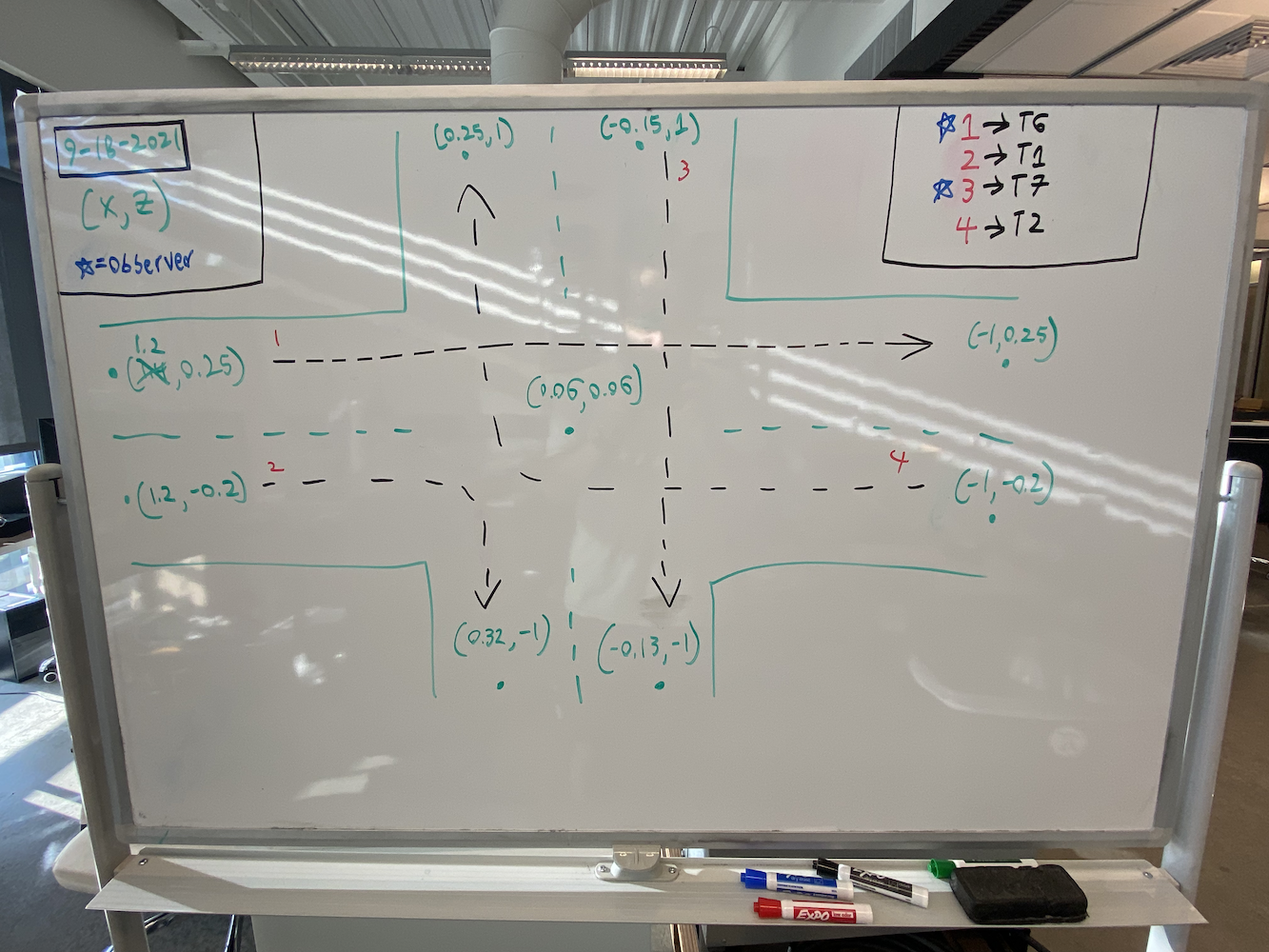

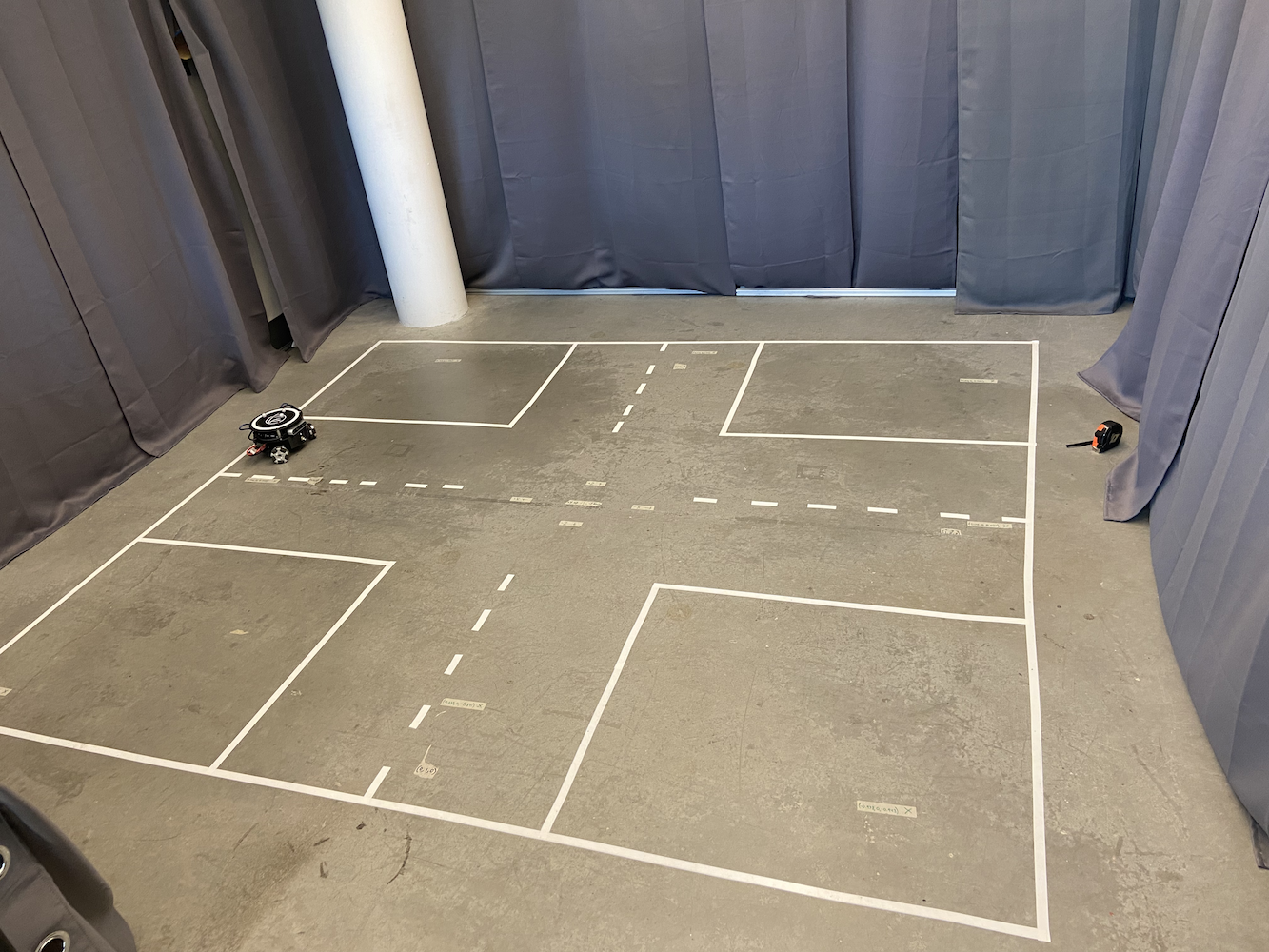

इसका समाधान करने के लिए, लैब ने एक क्षेत्र स्थापित किया जहाँ हम Triton पर नज़र रख सकते थे। इसके लिए, उन्होंने फर्श से लगभग 6-7 फीट ऊपर एक वर्गाकार आकार में 8 ऑप्टिट्रैक फ्लेक्स (इन्फ्रारेड रेड) कैमरों के साथ 2 मीटर बाय 2 मीटर का क्षेत्र बनाया।

|

|

इस क्षेत्र के निर्माण के साथ, प्रत्येक Triton के शरीर के शीर्ष पर तीन ग्रे गोल गेंदें जुड़ी हुई थीं।

इस सेटअप के साथ, हमने प्रभावी रूप से अपना एक छोटा-स्केल GPS सिस्टम बनाया जो हमें हमारे रुचि के क्षेत्र में Triton के सटीक समन्वय मीटर में प्राप्त करने की अनुमति देता था। Optitrack इन्फ्रारेड कैमरों और ऑप्टिट्रैक ग्रे गोलों का त्रिकोणीय आकार में उपयोग करके, हम अपने क्षेत्र में Triton के सटीक समन्वय को पहचान सकते थे। इससे हमें बेहतर सटीकता के लिए एक बंद-लूप प्रणाली लागू करने की अनुमति मिली।

Optitrack प्रणाली ने उचित रूप से कैलिब्रेट किए जाने पर लगभग 120Hz पर उप-मिलीमीटर सटीकता के साथ स्थिति और अभिविन्यास डेटा प्रदान किया। प्रत्येक Triton के तीन परावर्तक मार्करों ने एक अद्वितीय त्रिकोणीय पैटर्न बनाया जिसे प्रणाली एक कठोर शरीर के रूप में ट्रैक कर सकती थी। समन्वय प्रणाली को इस तरह से कैलिब्रेट किया गया था कि (0,0) ट्रैकिंग क्षेत्र के केंद्र में था, X और Y अक्ष कमरे की ज्यामिति के अनुरूप थे। लेकिन इस सटीक स्थिति डेटा के बावजूद, Triton अभी भी आंदोलन में संघर्ष कर रहा था।

इस सेटअप के साथ, एक मुख्य विशेषता जिसे हम Triton को प्रदान करना चाहते थे, वह थी एक विशिष्ट समन्वय पर जाने की क्षमता। उपयोगकर्ता, या उनका सॉफ़्टवेयर, अपने रुचि के क्षेत्र में (x, y) समन्वय प्रदान कर सकता था। फिर रोबोट उस समन्वय पर जितनी तेजी से, सटीकता से, और निर्बाध रूप से संभव हो सके, जाएगा। जब मैं शामिल हुआ, तो यह विशेषता मौजूद थी लेकिन यह बहुत अच्छी तरह से काम नहीं कर रही थी। यहाँ एक सरल एनीमेशन है जो दिखाता है कि मूल आंदोलन तर्क कैसे काम करता था:

मैंने मूल समाधान को क्रियान्वित करते हुए रिकॉर्ड नहीं किया, इसलिए मैंने आपको पुराने आंदोलन तर्क को क्रियान्वित करते हुए दिखाने के लिए यह सरल एनीमेशन बनाया। यह जानकर, इस विधि के साथ क्या समस्याएँ थीं?

- यह वास्तव में धीमा है

- यह रोबोट को एक विशिष्ट बिंदु पर जाने के लिए बहुत अधिक स्थान लेता है। इससे हमें इस समाधान का उपयोग करना कठिन हो गया जब कई Tritons चारों ओर घूम रहे थे।

तो यह व्यवहार क्यों हो रहा था? समस्या यह थी कि Triton पहले मुड़ता था, अपने अल्फा को बदलता था, जब तक कि यह एक विशिष्ट त्रुटि सीमा के भीतर लक्ष्य बिंदु की ओर इशारा नहीं करता था। फिर यह आगे की ओर दौड़ता था, और जब इसका थेटा लक्ष्य से एक विशिष्ट मात्रा में भटक जाता था, तो यह रुक जाता था और फिर से मुड़ना शुरू कर देता था जब तक कि अल्फा उस लक्ष्य के लिए स्वीकार्य सीमा के भीतर नहीं आ जाता था। फिर यह फिर से दौड़ता है और यह तब तक करता रहता है जब तक यह बिंदु पर नहीं पहुँच जाता। इसके अलावा, जैसे-जैसे यह लक्ष्य बिंदु के करीब पहुँचता गया, मुड़ने और दौड़ने की गति बहुत धीमी हो जाती थी ताकि यह ओवरशूट न करे। इसके परिणामस्वरूप Triton का अस्वाभाविक आंदोलन हुआ, लक्ष्य बिंदु पर पहुँचने में बहुत समय लगा, और एक विशिष्ट लक्ष्य बिंदु पर पहुँचने के लिए बहुत अधिक क्षेत्र की आवश्यकता थी। इसलिए इन सभी समस्याओं के साथ, और इस विशेषता के Triton परियोजना के विकास के लिए कितनी आवश्यक थी, जब मैंने HCR लैब में काम करना शुरू किया, तो मेरा पहला कार्य अधिक प्रभावी समाधान विकसित करना था जो Triton को लक्ष्य बिंदु पर बेहतर तरीके से नेविगेट करने की अनुमति देता।

यह जानकर, मैंने इस समस्या को हल करने के सर्वोत्तम संभव तरीके पर शोध करने में बहुत समय बिताया। विडंबना यह है कि मैं माइन में फीडबैक नियंत्रण प्रणालियों का परिचय (EENG307) नामक एक कक्षा ले रहा था। उस कक्षा में, हमने ओपन-लूप नियंत्रकों और बंद-लूप नियंत्रकों के सिद्धांत के बारे में सीखा। यह जानकर, और उस कक्षा के प्रोफेसर और मेरे स्मार्ट रूममेट के साथ कुछ चर्चा के बाद, यह स्पष्ट हो गया कि Triton को लक्ष्य बिंदु पर लाने का यह लक्ष्य एक बंद-लूप प्रणाली की समस्या थी।

अब, व्यापक परीक्षण और अनुसंधान के बाद, मैंने Tritons के लिए दो अलग-अलग नियंत्रक दृष्टिकोण विकसित किए:

विधि 1: दूरी-थेटा नियंत्रक

इस दृष्टिकोण ने दो अलग-अलग अनुपात नियंत्रकों का उपयोग किया जो एक साथ चल रहे थे:

- दूरी नियंत्रक: लक्ष्य तक की यूक्लिडियन दूरी की गणना की और आगे/पीछे की गति निर्धारित करने के लिए अनुपात लाभ लागू किया

- थेटा नियंत्रक: रोबोट के वर्तमान दिशा और लक्ष्य की इच्छित दिशा के बीच कोणीय त्रुटि की गणना की, घूर्णन गति के लिए एक अलग अनुपात लाभ लागू किया

एल्गोरिदम लगातार लक्ष्य तक की यूक्लिडियन दूरी और रोबोट के वर्तमान दिशा और इच्छित दिशा के बीच कोणीय त्रुटि की गणना करता था। रैखिक और कोणीय गति उत्पन्न करने के लिए दो अलग-अलग अनुपात लाभ लागू किए गए।

इसके परिणामस्वरूप Triton स्वाभाविक रूप से लक्ष्य की ओर मुड़ता था जबकि एक साथ आगे बढ़ता था, चिकनी वक्र पथ बनाता था। मुख्य लाभ यह था कि रोबोट हमेशा अपने सामने के चेहरे को गंतव्य की ओर उन्मुख रखता था, जो कैमरा-आधारित अनुप्रयोगों के लिए महत्वपूर्ण था।

विधि 2: X-Y समन्वय नियंत्रक

इस दृष्टिकोण ने रोबोट को 2D प्लॉटर की तरह माना, जिसमें X और Y गति का स्वतंत्र नियंत्रण था:

- X नियंत्रक: X-निर्देशांक त्रुटि के आधार पर पूर्व-पश्चिम गति को सीधे नियंत्रित किया

- Y नियंत्रक: Y-निर्देशांक त्रुटि के आधार पर उत्तर-दक्षिण गति को सीधे नियंत्रित किया

इस कार्यान्वयन ने स्वतंत्र रूप से X और Y निर्देशांक त्रुटियों की गणना की, अलग-अलग अनुपात लाभ लागू किए, और फिर इन वैश्विक वेग घटकों को रोबोट के स्थानीय निर्देशांक फ्रेम में घूर्णन मैट्रिक्स का उपयोग करके परिवर्तित किया। यह परिवर्तन आवश्यक था क्योंकि रोबोट के ओम्नी-व्हील ड्राइवट्रेन को अपने संदर्भ फ्रेम में वेग की आवश्यकता थी, न कि वैश्विक निर्देशांकों में। इस विधि ने लक्ष्यों के लिए सबसे सीधे रास्ते उत्पन्न किए और यह काफी तेज़ थी, लेकिन रोबोट का सिरा भटक जाएगा क्योंकि कोई स्पष्ट अभिविन्यास नियंत्रण नहीं था।

विधि #1 के लिए, मैंने इस विधि के बारे में पूरी जानकारी दी है मेरे मूव कछुआ (TurtleSim) ब्लॉग में। मैं अत्यधिक अनुशंसा करता हूँ कि आप इस ब्लॉग को पढ़ें ताकि आपको PID नियंत्रकों के काम करने के तरीके के बारे में सभी विवरण मिल सकें, साथ ही विधि #1 कैसे काम करती है। मैंने विधि #1 को ROS के TurtleSim का उपयोग करके विकसित किया, फिर उस कोड को ट्राइटन में स्थानांतरित किया और इसे अधिक वास्तविक दुनिया के वातावरण के लिए अपडेट किया।

विधि #2 ने एक काफी अलग लेकिन समान रूप से प्रभावी दृष्टिकोण का उपयोग किया। रोबोट के अभिविन्यास और लक्ष्य की दूरी के बारे में सोचने के बजाय, यह विधि गति को एक समन्वय विमान समस्या के रूप में मानती है। नियंत्रक लगातार X और Y दिशाओं में त्रुटियों की गणना करता है। उदाहरण के लिए, यदि रोबोट को (0,0) से (2,3) तक जाना है, तो यह इसे X में 2 मीटर की त्रुटि और Y में 3 मीटर की त्रुटि को सही करने के रूप में देखता है। दो अनुपात नियंत्रक एक साथ काम करते थे: एक ने X-त्रुटि के आधार पर रोबोट की गति को X दिशा में समायोजित किया, जबकि दूसरे ने Y-त्रुटि के आधार पर Y दिशा में गति को संभाला। इसने लक्ष्य की ओर एक अधिक सीधा रास्ता बनाया, जैसे कि एक 3D प्रिंटर का सिर चलता है, और चिकनी तिरछी गति की अनुमति दी। रोबोट को अपने लक्ष्य का सामना करने के लिए स्पष्ट रूप से मुड़ने की आवश्यकता नहीं थी, जिससे यह विधि तंग स्थानों में या जब सटीक स्थिति की आवश्यकता होती है, तो विशेष रूप से प्रभावी हो गई।

दोनों विधियों ने मूल दृष्टिकोण की तुलना में काफी तेज़ और अधिक विश्वसनीय साबित किया। इन नई विधियों को क्रियान्वित होते देखने के लिए, ट्राइटन्स इन एक्शन प्लेलिस्ट देखें, जो सभी ट्राइटन्स को नई विधियों के साथ क्रियान्वित करते हुए दिखाती है।

जो पहले 30-45 सेकंड में एक साधारण बिंदु-से-बिंदु आंदोलन के लिए लगता था, वह अब लगभग 8-12 सेकंड में हो गया। अधिक महत्वपूर्ण बात यह है कि ट्राइटन अब तंग स्थानों में अधिक कुशलता से नेविगेट कर सकता था, जो हमारे बहु-रोबोट परिदृश्यों के लिए उपयोगी हो गया।

विकास चुनौतियाँ और डिबगिंग

इन नियंत्रकों को लागू करना सीधा नहीं था और इसमें कई महत्वपूर्ण डिबगिंग चुनौतियाँ शामिल थीं:

समन्वय प्रणाली परिवर्तन: सबसे कठिन पहलुओं में से एक समन्वय परिवर्तनों को सही करना था। ऑप्टिट्रैक प्रणाली ने अपने स्वयं के समन्वय फ्रेम में डेटा प्रदान किया, रोबोट का अपना स्थानीय समन्वय फ्रेम था, और मुझे उनके बीच सटीक रूप से परिवर्तित करना था। प्रारंभिक कार्यान्वयन में रोबोट गलत दिशाओं में चल रहे थे क्योंकि मैंने घूर्णन मैट्रिक्स गणनाओं को मिलाया था।

वास्तविक-विश्व बनाम आदर्श व्यवहार: सबसे बड़ी चुनौती उन वास्तविक-विश्व कारकों को ध्यान में रखना था जो पाठ्यपुस्तक नियंत्रण सिद्धांत में नहीं दिखाई देते। रोबोट के पहियों में विभिन्न घर्षण विशेषताएँ थीं, मोटर्स समान रूप से प्रतिक्रिया नहीं देते थे, और ऑप्टिट्रैक से नियंत्रण सॉफ़्टवेयर से रोबोट के आर्डुइनो तक संचार श्रृंखला में हमेशा कुछ विलंब होता था। मैंने इन भौतिक वास्तविकताओं को ध्यान में रखते हुए अनुपात लाभ को ट्यून करने और डेडबैंड फ़िल्टर जोड़ने में सप्ताह बिताए।

कंपन और स्थिरता मुद्दे: मेरे पहले कार्यान्वयन में कंपन समस्याओं का सामना करना पड़ा जहाँ रोबोट अपने लक्ष्यों को ओवरशूट करते थे और आगे-पीछे झूलते थे। इसने मुझे PID नियंत्रकों में व्युत्क्रम शर्तों के महत्व और उचित लाभ ट्यूनिंग की आवश्यकता के बारे में सिखाया। मैंने अंततः पूरी तरह से PID के बजाय सावधानीपूर्वक ट्यून किए गए लाभों के साथ मुख्य रूप से अनुपात नियंत्रण पर समझौता किया, क्योंकि प्रणाली की अंतर्निहित डैम्पिंग अधिकांश अनुप्रयोगों के लिए पर्याप्त थी।

बहु-रोबोट हस्तक्षेप: जब कई रोबोट एक साथ काम कर रहे थे, तो मैंने अप्रत्याशित हस्तक्षेप पैटर्न का पता लगाया। रोबोट कभी-कभी एक ही स्थान पर “लड़ाई” करते थे या ऐसी स्थिति उत्पन्न करते थे जहाँ वे एक-दूसरे को अनिश्चितकाल के लिए अवरुद्ध कर देते थे। इससे मुझे समन्वय तंत्र और टकराव से बचने वाले एल्गोरिदम को लागू करने के लिए प्रेरित किया।

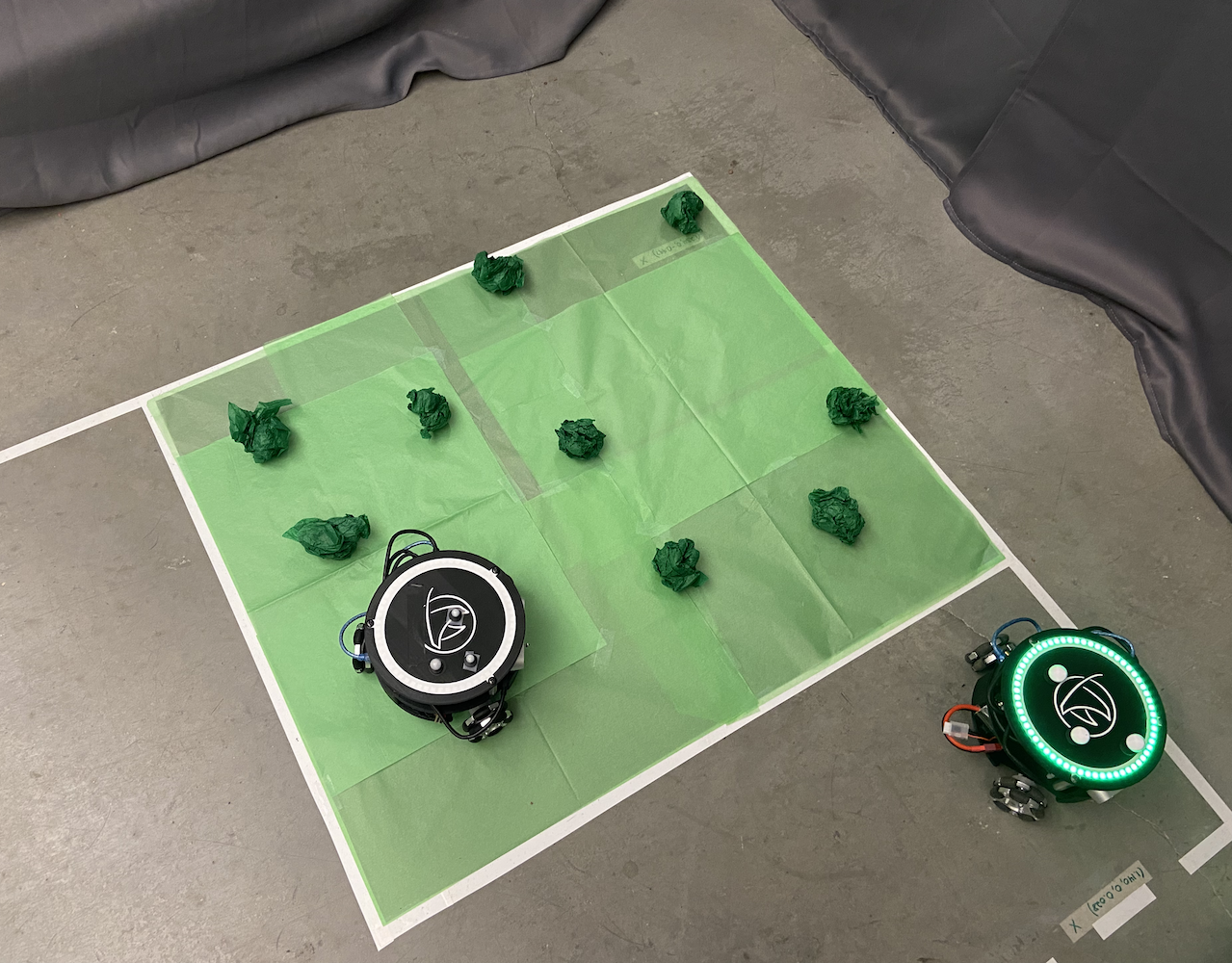

बहु-ट्राइटन नियंत्रण प्रणाली

एक बार जब मैंने एकल ट्राइटन आंदोलन की समस्या को हल कर लिया, तो प्रयोगशाला की अगली चुनौती थी कि कई ट्राइटन्स को एक साथ काम करने के लिए प्राप्त करना। यह मेरे मुख्य ध्यान क्षेत्रों में से एक बन गया और परियोजना में एक महत्वपूर्ण योगदान बन गया।

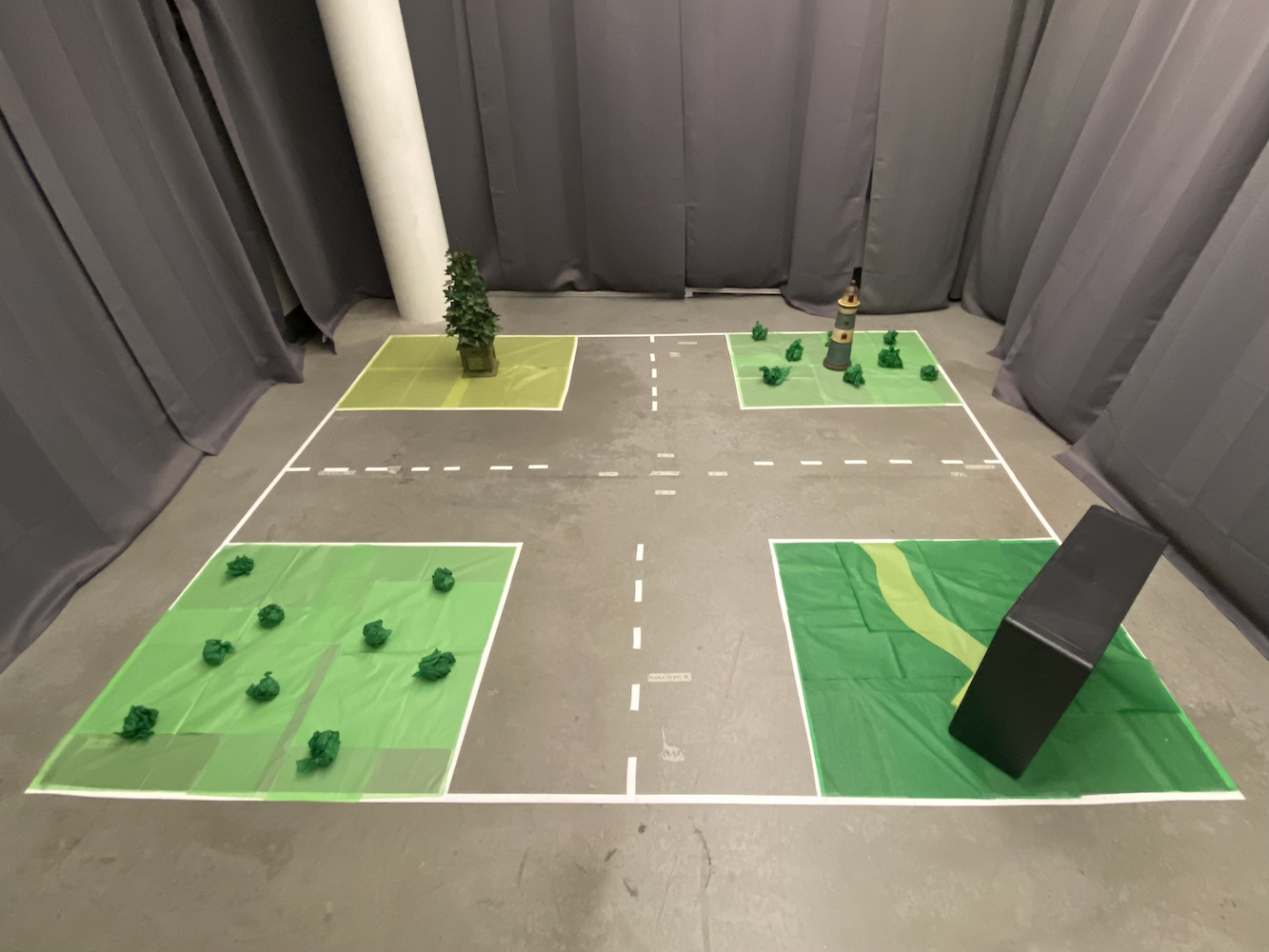

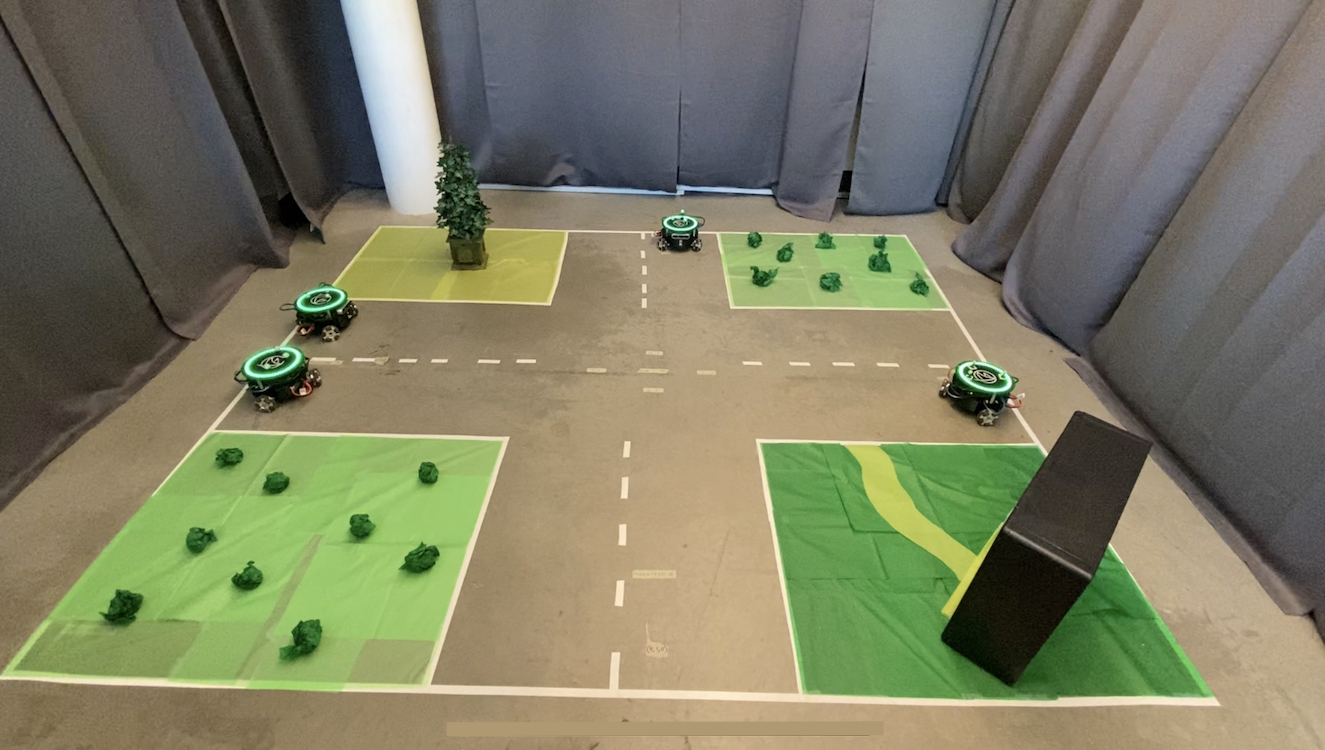

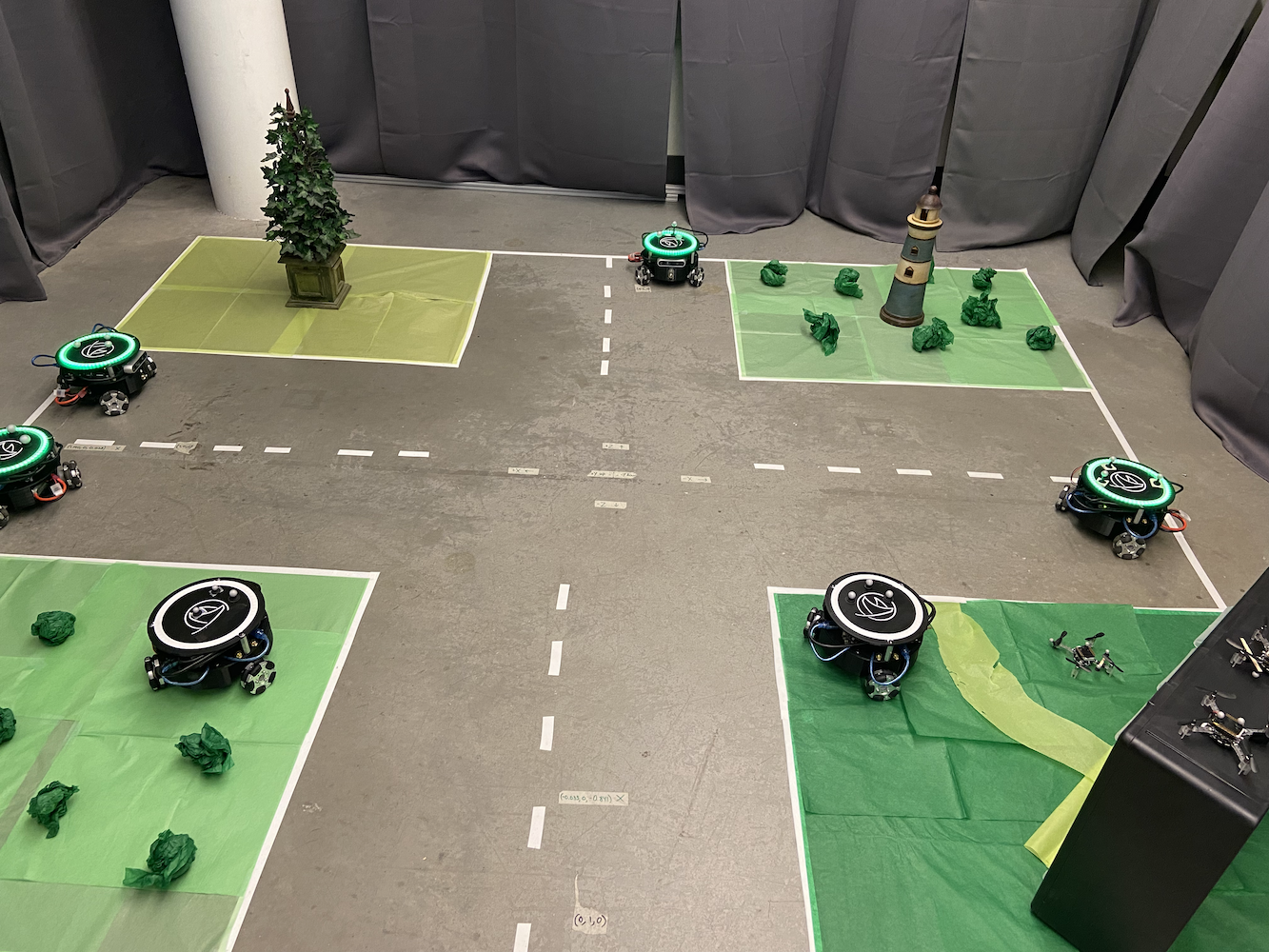

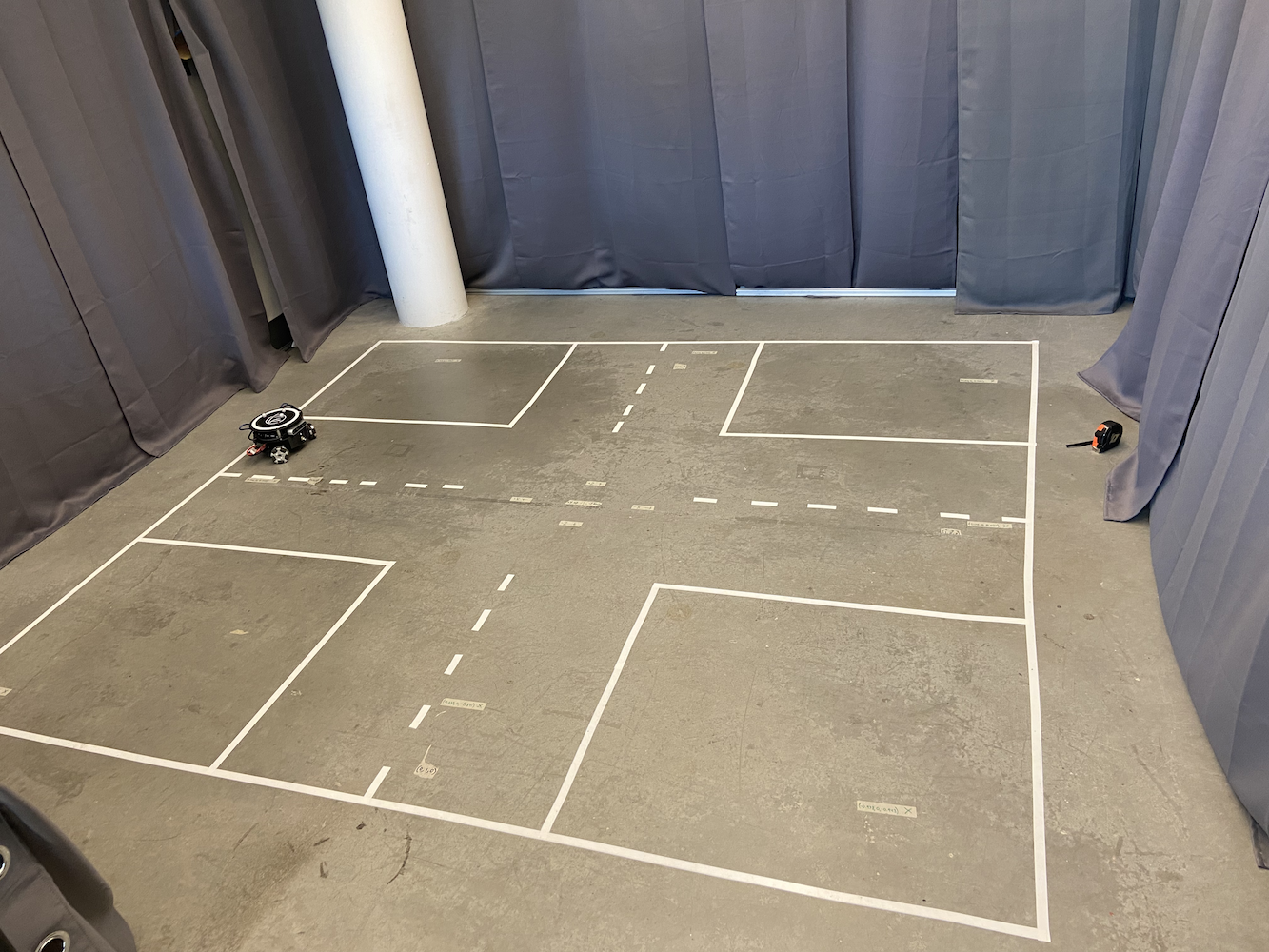

मूल प्रणाली केवल एक समय में एक ट्राइटन को नियंत्रित कर सकती थी, जिससे शोध की संभावनाएँ गंभीर रूप से सीमित हो गईं। प्रयोगशाला ने ऐसे परिदृश्यों का अनुकरण करना चाहा जहाँ कई स्वायत्त वाहनों को अपने आंदोलनों का समन्वय करना था, जैसे कि स्व-ड्राइविंग कारें एक-दूसरे के साथ संवाद करती हैं ताकि ट्रैफ़िक प्रवाह को अनुकूलित किया जा सके और बेहतर SLAM (समानांतर स्थानीयकरण और मानचित्रण) मानचित्र बनाए जा सकें।

इसका समाधान करने के लिए, मैंने पायथन के मल्टीप्रोसेसिंग पुस्तकालय का उपयोग करके एक मल्टी-प्रोसेसिंग दृष्टिकोण लागू किया। प्रत्येक ट्राइटन को अपना समर्पित प्रक्रिया मिली जो स्वतंत्र रूप से चल सकती थी जबकि फिर भी एक केंद्रीय नियंत्रण प्रणाली द्वारा समन्वित थी। इससे कई ट्राइटन्स को एक साथ चलने की अनुमति मिली बिना एक-दूसरे के नियंत्रण लूप में हस्तक्षेप किए।

बहु-रोबोट आर्किटेक्चर डिज़ाइन

मैंने जो प्रणाली आर्किटेक्चर विकसित किया, उसमें कई प्रमुख घटक शामिल थे:

मुख्य नियंत्रक प्रक्रिया: यह केंद्रीय समन्वयक के रूप में कार्य करता था, उपयोगकर्ता इंटरफ़ेस इंटरैक्शन, पथ योजना, और रोबोटों के बीच उच्च-स्तरीय समन्वय को संभालता था। यह वैश्विक स्थिति बनाए रखता था और व्यक्तिगत रोबोट प्रक्रियाओं को आदेश वितरित करता था।

व्यक्तिगत रोबोट प्रक्रियाएँ: प्रत्येक ट्राइटन के पास अपना समर्पित पायथन प्रक्रिया थी जो संभालती थी:

- ~50Hz पर वास्तविक समय PID नियंत्रण गणनाएँ

- रोबोट के हार्डवेयर (आर्डुइनो/जेटसन) के साथ संचार

- स्थानीय पथ निष्पादन और बाधा से बचाव

- मुख्य नियंत्रक को स्थिति रिपोर्टिंग

साझा मेमोरी संचार: मैंने प्रक्रियाओं के बीच कुशल संचार सक्षम करने के लिए पायथन के multiprocessing.shared_memory और Queue वस्तुओं का उपयोग किया। इससे वास्तविक समय समन्वय संभव हुआ बिना नेटवर्क संचार के ओवरहेड के।

समन्वय तंत्र: जब कई रोबोटों को समन्वयित करने की आवश्यकता होती थी (जैसे टकराव से बचने के लिए), मैंने सेमाफोर और लॉक लागू किए जो रोबोटों को कार्यक्षेत्र के कुछ क्षेत्रों तक विशेष पहुंच का अनुरोध करने की अनुमति देते थे।

चुनौती यह थी कि सभी रोबोट अपने नियंत्रण लूप को स्वतंत्र रूप से संचालित कर सकें जबकि फिर भी वैश्विक समन्वय बनाए रखें। प्रत्येक रोबोट प्रक्रिया अपने PID गणनाएँ चलाती थी और मोटर आदेशों को सीधे हार्डवेयर को भेजती थी, जबकि मुख्य प्रक्रिया उच्च-स्तरीय समन्वय जैसे टकराव से बचाव और पथ योजना को संभालती थी।

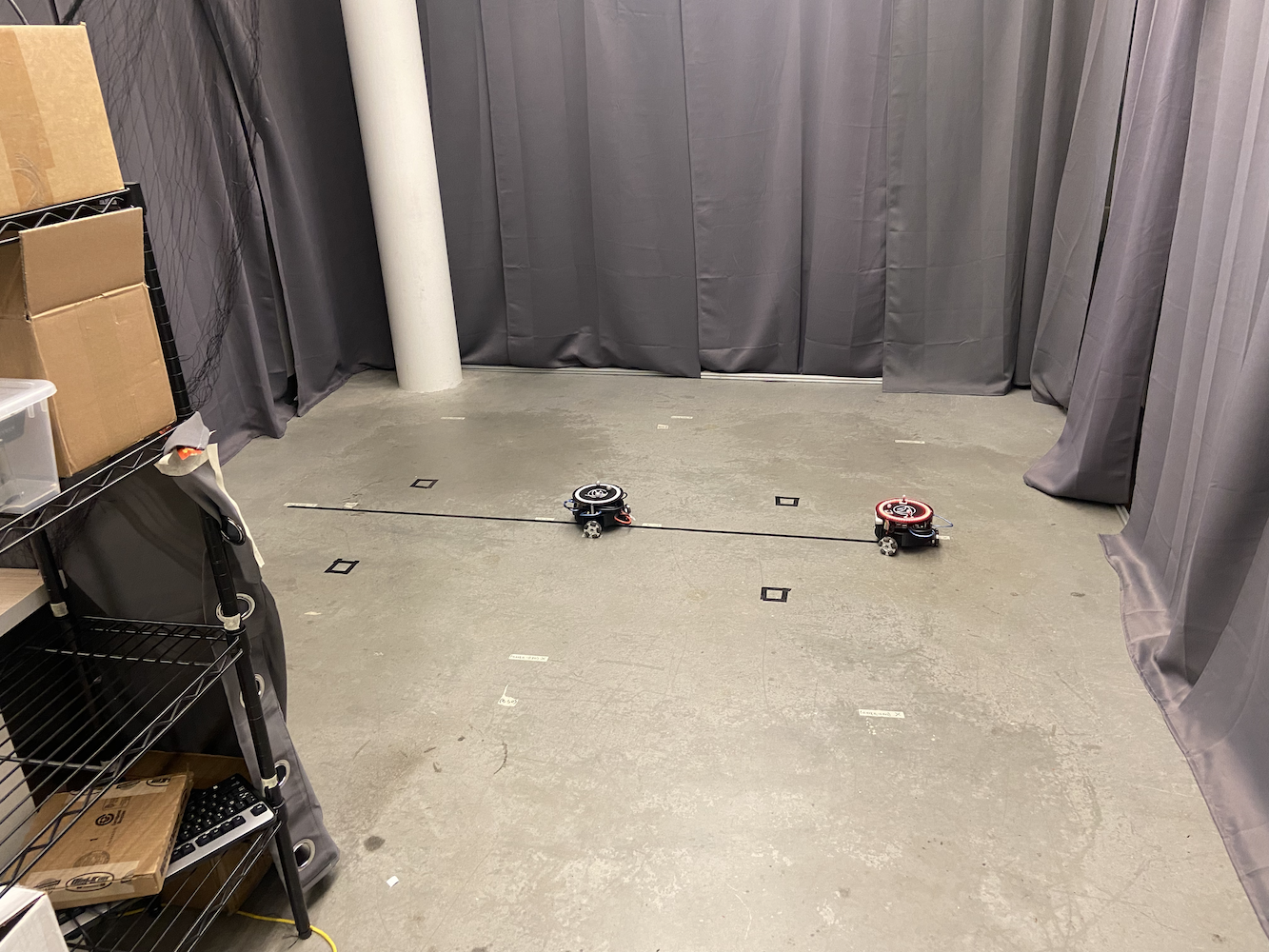

|

|

बहु-ट्राइटन प्रणाली ने पूरी तरह से नए शोध की संभावनाएँ खोलीं। हम अब अनुकरण कर सकते थे:

- वाहन-से-वाहन संचार परिदृश्य

- बाधा से बचाव के साथ समन्वित पथ योजना

- स्वार्म रोबोटिक्स व्यवहार

- बहु-एजेंट SLAM मानचित्रण

- गठन नियंत्रण और अनुसरण व्यवहार

यहाँ प्रयोगशाला सेटअप का दृश्य है जिसमें कई ट्राइटन्स एक साथ चल रहे हैं:

|

|

मैंने एक उपयोगकर्ता-अनुकूल इंटरफ़ेस भी विकसित किया जो शोधकर्ताओं को प्रत्येक ट्राइटन के लिए पथ को दृश्य रूप से परिभाषित करने की अनुमति देता था। आप वास्तव में उस पथ को खींच सकते थे जिसे आप चाहते थे कि प्रत्येक रोबोट अनुसरण करे, और वे इन पथों को पूर्ण समन्वय के साथ निष्पादित करते थे। यह जटिल प्रयोगों को सेट अप करने के लिए बेहद उपयोगी था बिना हर आंदोलन को मैन्युअल रूप से कोड किए।

यह प्रणाली एक साथ 5 ट्राइटन्स को संभाल सकती थी, प्रत्येक अपने PID नियंत्रकों को चलाते हुए जबकि केंद्रीय नियंत्रण प्रणाली के माध्यम से समन्वित थी। प्रदर्शन प्रभावशाली था, सभी रोबोट अपनी व्यक्तिगत सटीकता बनाए रखते हुए एक टीम के रूप में काम कर रहे थे।

यहाँ एक प्लेलिस्ट है जो ट्राइटन्स को क्रियान्वित करते हुए दिखाती है, एकल-रोबोट नियंत्रण से लेकर बहु-रोबोट समन्वय तक: ट्राइटन्स इन एक्शन प्लेलिस्ट

गहराई सेंसर एकीकरण और समन्वय सुधार

एक और प्रमुख उन्नति जिसमें मैंने काम किया, वह थी प्रत्येक ट्राइटन पर लगे Intel RealSense D435 गहराई कैमरों का उपयोग करना। जबकि ऑप्टिट्रैक प्रणाली ने हमें अत्यधिक सटीक स्थिति डेटा दिया, मैं यह पता लगाना चाहता था कि रोबोट अपने ऑनबोर्ड सेंसर का उपयोग करके अपने स्थानिक जागरूकता को कैसे सुधार सकते हैं और समन्वय त्रुटियों को सही कर सकते हैं।

विचार यह था कि ट्राइटन्स अपने गहराई सेंसर का उपयोग करके अपने निकटवर्ती अन्य ट्राइटन्स का पता लगा सकते हैं और उनके स्थानों का क्रॉस-रेफरेंस कर सकते हैं। इसका कई उद्देश्यों के लिए उपयोग किया जाएगा:

-

त्रुटि सुधार: यदि ऑप्टिट्रैक प्रणाली में कोई कैलिब्रेशन ड्रिफ्ट या अस्थायी अवरोध था, तो रोबोट एक-दूसरे के स्थानों की दृश्य पुष्टि का उपयोग करके सटीक समन्वय प्रणाली बनाए रख सकते थे।

-

सुधारित SLAM: कई रोबोटों के साथ गहराई सेंसर का उपयोग करके, हम पर्यावरण के बहुत समृद्ध मानचित्र बना सकते थे जिसमें अतिरिक्त डेटा बिंदु होते थे।

-

टकराव से बचाव: वास्तविक समय की गहराई संवेदन से रोबोटों को एक-दूसरे का पता लगाने और बचने की अनुमति मिलेगी, भले ही केंद्रीय नियंत्रण प्रणाली में संचार में देरी हो।

मैंने ऐसे एल्गोरिदम के साथ प्रयोग करना शुरू किया जो ट्राइटन्स को सक्षम बनाते हैं:

- उनके विशिष्ट त्रिकोणीय आकार और परावर्तक गोला मार्करों का उपयोग करके अन्य ट्राइटन्स का पता लगाना

- गहराई डेटा का उपयोग करके सापेक्ष स्थिति और अभिविन्यास की गणना करना

- इन मापों की तुलना ऑप्टिट्रैक डेटा से करना ताकि विसंगतियों की पहचान की जा सके

- सटीकता बनाए रखने के लिए वास्तविक समय में उनके समन्वय प्रणाली को संभावित रूप से समायोजित करना

कंप्यूटर दृष्टि प्रयोग

मैंने एक कंप्यूटर दृष्टि पाइपलाइन के साथ प्रयोग करने में काफी समय बिताया जो कई चरणों में काम करती थी:

|

|

|

|

|

गहराई डेटा प्रसंस्करण: इंटेल रियलसेंस D435 ने RGB और गहराई डेटा स्ट्रीम दोनों प्रदान किए। मैंने मुख्य रूप से गहराई डेटा के साथ काम किया, जो 30Hz पर दूरी मापों के 640x480 एरे के रूप में आया। पहली चुनौती इस शोर भरे गहराई डेटा को फ़िल्टर करना था ताकि अर्थपूर्ण ज्यामितीय जानकारी निकाली जा सके।

वस्तु पहचान प्रयास: मैंने बहु-चरण पहचान एल्गोरिदम के साथ प्रयोग किया। मुझे फर्श स्तर पर वस्तुओं की पहचान के लिए गहराई छवि को विभाजित करने में कुछ सफलता मिली (दीवारों, छत आदि को फ़िल्टर करते हुए) और सही आकार की विशेषताओं वाली वस्तुओं की तलाश की, लगभग 0.3x0.3 मीटर का फुटप्रिंट। मैंने विशिष्ट ट्राइटन प्रोफ़ाइल की पहचान के लिए किनारे पहचान और ज्यामितीय विश्लेषण का उपयोग करने की कोशिश की, जिसमें मिश्रित परिणाम मिले।

मार्कर पहचान प्रयोग: प्रत्येक ट्राइटन पर तीन परावर्तक गोले सबसे आशाजनक पहचान विशेषता लग रहे थे। मैंने गहराई छवि में तीन उज्ज्वल बिंदुओं के त्रिकोणीय पैटर्न की पहचान के लिए ब्लॉब पहचान एल्गोरिदम के साथ प्रयोग किया। मुझे नियंत्रित प्रकाश स्थितियों में कुछ आशाजनक परिणाम मिले, हालांकि यह लगातार विश्वसनीय नहीं था।

समन्वय फ्यूजन अनुसंधान: मैंने दृष्टि-आधारित स्थिति अनुमान को ऑप्टिट्रैक डेटा के साथ फ्यूज करने के लिए दृष्टिकोणों पर शोध किया, जिसमें बुनियादी काल्मन फ़िल्टर कार्यान्वयन शामिल थे। अवधारणा यह थी कि उपलब्ध होने पर ऑप्टिट्रैक डेटा को अधिक वजन दिया जाए, लेकिन आवश्यकता पड़ने पर दृष्टि पर वापस लौटें, हालांकि मैं इसे अपने समय के अंत से पहले पूरी तरह से कार्यान्वित नहीं कर सका।

प्रदर्शन चुनौतियाँ: रोबोट के नियंत्रण लूप के साथ वास्तविक समय में सभी प्रसंस्करण को चलाना चुनौतीपूर्ण साबित हुआ। मैंने जेटसन नैनो की प्रसंस्करण क्षमताओं को अधिकतम किए बिना लगभग 10-15Hz पर एल्गोरिदम चलाने के लिए अनुकूलन दृष्टिकोणों के साथ प्रयोग किया।

दुर्भाग्यवश, मुझे प्रयोगशाला छोड़ने से पहले इस कंप्यूटर दृष्टि कार्य को पूरी तरह से पूरा करने के लिए छोड़ना पड़ा। जबकि मुझे कुछ आशाजनक प्रारंभिक परिणाम मिले और गहराई संवेदक प्रसंस्करण के बारे में बहुत कुछ सीखा, मैं प्रणाली को पूरी तरह से विश्वसनीय स्थिति में नहीं ला सका। यह एक दिलचस्प अनुसंधान दिशा बनी रही जिस पर अन्य लोग संभावित रूप से निर्माण कर सकते थे।

यहाँ एक वीडियो है जिसमें मैं कंप्यूटर दृष्टि एल्गोरिदम का परीक्षण कर रहा हूँ:

यहाँ मेरे प्रयोगों के दौरान गहराई संवेदक दृश्य कैसा दिखता था:

हालांकि मैंने गहराई संवेदक एकीकरण कार्य को पूरा नहीं किया, अवधारणा ने स्व-ड्राइविंग कार परिदृश्यों का अनुकरण करने के लिए संभावनाएँ दिखाई, जहाँ वाहनों को एक-दूसरे के बारे में जागरूक होना आवश्यक है बिना केवल बाहरी बुनियादी ढांचे पर निर्भर किए। मैंने जो अनुसंधान दिशा शुरू की, वह भविष्य के कार्य में प्रयोगशाला में योगदान कर सकती है।

दस्तावेज़ीकरण और ज्ञान संरक्षण

HCR प्रयोगशाला में मेरा सबसे महत्वपूर्ण योगदान, और शायद जिस पर मुझे सबसे अधिक गर्व है, वह सभी परियोजना दस्तावेज़ों का आयोजन और संरक्षण करना था। जब मैं प्रयोगशाला में शामिल हुआ, तो ट्राइटन परियोजना का ज्ञान कई प्लेटफार्मों और प्रारूपों में बिखरा हुआ था। महत्वपूर्ण जानकारी विभिन्न स्थानों पर फैली हुई थी:

- विभिन्न गूगल ड्राइव खातों में जो विभिन्न छात्रों के थे जो स्नातक हो चुके थे

- पुराने ईमेल जो इनबॉक्स में दबे हुए थे

- यादृच्छिक ड्रॉपबॉक्स फ़ोल्डर

- कई गिटहब रिपॉजिटरी

- गिटलैब रिपॉजिटरी जिनका संगठन असंगत था

- हस्तलिखित नोट्स जिन्हें केवल कुछ विशेष लोग ही समझ सकते थे

यह बिखरा हुआ दस्तावेज़ीकरण एक बड़ा समस्या था। नए छात्रों को शुरू करने के लिए केवल सप्ताहों का समय लग जाता था, और जब लोग स्नातक होते या प्रयोगशाला छोड़ते, तो मूल्यवान ज्ञान लगातार खो जाता था।

मैंने इस समस्या को व्यवस्थित रूप से हल करने का निर्णय लिया। मैंने ट्राइटन परियोजना से संबंधित हर दस्तावेज़, कोड, वीडियो और नोट को ट्रैक करने में अनगिनत घंटे बिताए। फिर मैंने सब कुछ एक केंद्रीकृत गिटलैब रिपॉजिटरी में स्पष्ट, तार्किक संरचना के साथ व्यवस्थित किया।

|

|

केंद्रीकृत दस्तावेज़ीकरण में शामिल थे:

- निर्माण गाइड: ट्राइटन्स को शून्य से असेंबल करने के लिए चरण-दर-चरण निर्देश

- सॉफ़्टवेयर सेटअप: विकास वातावरण सेटअप के लिए पूर्ण गाइड

- कोड दस्तावेज़ीकरण: स्पष्ट व्याख्याओं के साथ अच्छी तरह से टिप्पणी किया गया कोड

- हार्डवेयर विशिष्टताएँ: विस्तृत भागों की सूची, वायरिंग आरेख, और पीसीबी डिज़ाइन

- समस्या निवारण गाइड: सामान्य समस्याएँ और उनके समाधान

- वीडियो ट्यूटोरियल: मैंने यूट्यूब पर शैक्षिक वीडियो बनाए और अपलोड किए, जिसमें विस्तृत ऑप्टिट्रैक कैलिब्रेशन ट्यूटोरियल शामिल हैं:

मैंने भविष्य के योगदानों को व्यवस्थित और सुलभ बनाने के लिए दस्तावेज़ीकरण मानकों की स्थापना भी की। मैंने जो रिपॉजिटरी संरचना बनाई, वह प्रयोगशाला में सभी बाद के कार्यों के लिए आधार बन गई।

केवल मौजूदा दस्तावेज़ीकरण को व्यवस्थित करने के अलावा, मैंने कई मूल गाइड और ट्यूटोरियल बनाए जो ज्ञान आधार में महत्वपूर्ण अंतराल को भरते थे। इनमें नए प्रयोगशाला सदस्यों के लिए विस्तृत सेटअप निर्देश, व्यापक समस्या निवारण गाइड, और जटिल प्रक्रियाओं के वीडियो वॉकथ्रू शामिल थे।

इसका प्रभाव तात्कालिक और स्थायी था। नए छात्र दिनों में गति प्राप्त कर सकते थे, सप्ताहों में नहीं। मैंने जो दस्तावेज़ीकरण रिपॉजिटरी बनाई, वह आज भी प्रयोगशाला द्वारा उपयोग की जा रही है, वर्षों बाद जब मैं चला गया। यह ट्राइटन परियोजना के लिए सत्य का एकमात्र स्रोत बन गई और भविष्य के शोधकर्ताओं के लिए अनगिनत घंटे/दिनों की बचत की।

मार्गदर्शन और ज्ञान हस्तांतरण

HCR प्रयोगशाला में मेरे समय का सबसे पुरस्कृत पहलुओं में से एक दूसरों को मार्गदर्शन करने और मैंने जो ज्ञान प्राप्त किया है, उसे साझा करने का अवसर था। जैसे-जैसे मेरा काम आगे बढ़ा और मैं ट्राइटन प्रणालियों के साथ अधिक अनुभवी हुआ, मैंने नए टीम सदस्यों को प्रशिक्षित करने की बढ़ती जिम्मेदारी ली।

प्रयोगशाला के उत्तराधिकारियों को मार्गदर्शन

जैसे ही मैं अंततः प्रयोगशाला छोड़ने की तैयारी कर रहा था ताकि मैं अपनी डिग्री और eBay में अपने काम पर ध्यान केंद्रित कर सकूं, मैंने सुनिश्चित किया कि मैं दो लोगों को पूरी तरह से प्रशिक्षित करूं जो मेरी departure के बाद ट्राइटन परियोजना को संभालेंगे। यह केवल उन्हें यह दिखाने के बारे में नहीं था कि चीजें कैसे काम करती हैं, यह सुनिश्चित करने के बारे में था कि वे वास्तव में अंतर्निहित सिद्धांतों को समझें ताकि वे नवाचार जारी रख सकें।

मैंने उनके साथ सप्ताह बिताए, निम्नलिखित पर काम करते हुए:

- PID नियंत्रण प्रणालियों के गणितीय आधार

- कई रोबोटों के समन्वय के लिए बहु-प्रसंस्करण आर्किटेक्चर

- गहराई संवेदक एकीकरण और कंप्यूटर दृष्टि एल्गोरिदम

- दस्तावेज़ीकरण प्रणाली और इसे बनाए रखने का तरीका

- डिबगिंग तकनीक और सामान्य विफलता मोड

ज्ञान हस्तांतरण बेहद गहन था। हम एक साथ वास्तविक डिबगिंग सत्रों के माध्यम से गए, मैंने उन्हें मौजूदा कोड को संशोधित और विस्तारित करने के लिए कहा, और मैंने सुनिश्चित किया कि वे स्वतंत्र रूप से नए ट्राइटन्स को शून्य से सेट कर सकें।

हाई स्कूल मार्गदर्शन कार्यक्रम

शायद इससे भी अधिक पुरस्कृत था हाई स्कूल के एक छात्र को प्रयोगशाला के आउटरीच कार्यक्रम के माध्यम से मार्गदर्शन करने का मेरा अनुभव। यह किसी को रोबोटिक्स, कंप्यूटर विज्ञान और अनुसंधान से परिचित कराने का एक शानदार अवसर था, जब वे अपनी शिक्षा के प्रारंभिक चरण में थे।

मैंने एक व्यापक पाठ्यक्रम तैयार किया जो कवर करता था:

कंप्यूटर विज्ञान के मूलभूत सिद्धांत:

- प्रोग्रामिंग अवधारणाएँ, जिसमें प्राथमिक भाषा के रूप में पायथन का उपयोग किया गया

- वस्तु-उन्मुख प्रोग्रामिंग का परिचय

- एल्गोरिदम और डेटा संरचनाओं की समझ

रोबोटिक्स अवधारणाएँ:

- संवेदक कैसे काम करते हैं और उनके साथ इंटरफेस कैसे किया जाता है

- एक्ट्यूएटर नियंत्रण और मोटर सिस्टम

- स्वायत्त प्रणालियों और फीडबैक नियंत्रण के मूल बातें

ROS (रोबोट ऑपरेटिंग सिस्टम):

- प्रकाशित/सदस्यता संदेश प्रणाली की समझ

- नोड और सेवाएँ बनाना

- लॉन्च फ़ाइलों और पैरामीटर सर्वरों के साथ काम करना

व्यावहारिक परियोजना कार्य:

- हमने ट्राइटन के सिर पर LED प्रणाली को नियंत्रित करने के लिए एक ROS सेवा बनाने पर सहयोग किया

- उसने हमारे मौजूदा सिस्टम के साथ एकीकृत होने वाला साफ, दस्तावेज़ित कोड लिखना सीखा

- उसने जो LED नियंत्रण सेवा बनाई, वह ट्राइटन कोडबेस का एक स्थायी हिस्सा बन गई

इस मार्गदर्शन को विशेष रूप से खास बनाने वाली बात यह थी कि मैंने उसे प्रोग्रामिंग के बारे में लगभग कुछ नहीं जानने से लेकर एक सक्रिय अनुसंधान परियोजना में महत्वपूर्ण कोड में योगदान करते हुए देखा। वह “चर क्या है?” पूछने से ROS संचार मुद्दों को स्वतंत्र रूप से डिबग करने और अपनी स्वयं की सेवा कार्यान्वयन लिखने तक गई।

उसने जो LED नियंत्रण प्रणाली विकसित की, उसने शोधकर्ताओं को सरल ROS आदेशों के माध्यम से ट्राइटन के सिर के LEDs के रंग और पैटर्न को आसानी से बदलने की अनुमति दी। यह सरल लग सकता है, लेकिन इसके लिए ROS आर्किटेक्चर, हार्डवेयर इंटरफेसिंग, और उचित सॉफ़्टवेयर डिज़ाइन पैटर्न को समझने की आवश्यकता थी। उसका योगदान आज भी प्रयोगशाला में उपयोग किया जा रहा है।

मेरे लिए मेंटरशिप उतनी ही शैक्षिक थी जितनी कि उसके लिए। इसने मुझे जटिल अवधारणाओं को समझने योग्य टुकड़ों में तोड़ने और वास्तव में यह सोचने के लिए मजबूर किया कि हम क्या कर रहे थे। किसी और को सिखाने से मैं एक बेहतर इंजीनियर और शोधकर्ता बना।

पीएचडी अनुसंधान के साथ सहयोग

मेरे प्रयोगशाला में बिताए गए समय के सबसे पेशेवर रूप से संतोषजनक पहलुओं में से एक पेंग के साथ निकटता से काम करना था, जो एक पीएचडी छात्र था जिसका अनुसंधान स्व-चालित कार एल्गोरिदम पर केंद्रित था। मैंने ट्राइटन प्रणाली में जो सॉफ़्टवेयर सुधार किए थे, उन्होंने उसके डॉक्टरेट अनुसंधान का समर्थन करने में मदद की।

पेंग के अनुसंधान को स्व-चालित कार परिदृश्यों का अनुकरण करने के लिए सटीक, विश्वसनीय बहु-रोबोट समन्वय की आवश्यकता थी। मेरे द्वारा आंदोलन नियंत्रण और बहु-रोबोट प्रणालियों में किए गए सुधारों से पहले, ये प्रयोग करना बहुत अधिक कठिन था। रोबोट धीमे, कम सटीक थे, और एक साथ काम नहीं कर सकते थे।

मेरे योगदान ने पेंग के अनुसंधान में कई क्षेत्रों में मदद की:

चौराहे प्रबंधन अध्ययन: बेहतर पीआईडी नियंत्रकों और बहु-रोबोट समन्वय के साथ, पेंग चौराहे के परिदृश्यों का अनुकरण कर सकता था जहां कई “वाहनों” (ट्राइटन) को अपने आंदोलनों का समन्वय करना था। बेहतर समय और स्थिति ने इन अध्ययनों को अधिक व्यवहार्य बनाने में मदद की।

वाहन-से-वाहन संचार: मैंने जो बहु-प्रसंस्करण ढांचा विकसित किया, उसने पेंग को अनुकरण किए गए वाहनों के बीच संचार प्रोटोकॉल लागू करने और परीक्षण करने की अनुमति दी। प्रत्येक ट्राइटन निर्णय ले सकता था जबकि अन्य के साथ समन्वय करते हुए, जैसे कि स्व-चालित कारों को काम करने की आवश्यकता हो सकती है।

एसएलएएम और मानचित्रण अनुसंधान: गहराई सेंसर एकीकरण कार्य ने पेंग को उसके समकालिक स्थानीयकरण और मानचित्रण अनुसंधान के लिए अतिरिक्त डेटा प्रदान किया। समन्वित संवेदन क्षमताओं वाले कई रोबोट होने से अधिक व्यापक मानचित्रण प्रयोगों की अनुमति मिली।

हमारे सहयोग को विशेष रूप से मूल्यवान बनाने वाली बात यह थी कि यह केवल मेरा अनुसंधान में मदद करना नहीं था, बल्कि यह एक वास्तविक साझेदारी थी। स्वायत्त वाहनों के सैद्धांतिक पहलुओं की पेंग की समझ ने मेरी व्यावहारिक कार्यान्वयन को सूचित करने में मदद की। उनकी प्रतिक्रिया और आवश्यकताओं ने मुझे प्रणालियों को अधिक मजबूत और सक्षम बनाने के लिए प्रेरित किया।

हमने प्रयोगशाला में एक साथ कई घंटे बिताए, परिदृश्यों को डिबग करते हुए, विभिन्न नियंत्रण रणनीतियों पर चर्चा करते हुए, और यह पता लगाते हुए कि ट्राइटन प्लेटफ़ॉर्म क्या हासिल कर सकता है। पेंग एक सहयोगी और एक मित्र दोनों बन गए, और उनके साथ काम करने ने मुझे यह सिखाया कि अकादमिक अनुसंधान वास्तव में कैसे काम करता है।

मैंने जो प्रणालियाँ बनाई, वे पेंग के शोध प्रबंध के काम का एक उपयोगी हिस्सा बन गईं। स्वायत्त वाहन प्रौद्योगिकी में अनुसंधान का समर्थन करने के लिए मेरी व्यावहारिक इंजीनियरिंग योगदानों को देखना वास्तव में संतोषजनक था। इसने मुझे यह महसूस कराया कि ठोस इंजीनियरिंग और अनुसंधान कैसे मिलकर उपयोगी परिणाम उत्पन्न कर सकते हैं।

यहां तक कि जब मैं प्रयोगशाला छोड़ गया, तब भी पेंग और मैं संपर्क में रहे। यह जानकर कि मेरा काम मेरे प्रस्थान के बाद भी महत्वपूर्ण अनुसंधान में योगदान देता रहा, अत्यधिक संतोषजनक था।

दृष्टिकोण: विकास का प्री-एलएलएम युग

यह ध्यान देने योग्य है कि यह सारा काम प्री-एलएलएम सॉफ़्टवेयर विकास के युग के दौरान पूरा किया गया था। यह सब 2020 से 2021 (मुख्य रूप से 2021) के बीच हुआ, इससे पहले कि ChatGPT, Claude, Perplexity, या Cursor IDE जैसे एआई-संचालित विकास उपकरण मौजूद थे।

कोड की हर पंक्ति को शून्य से लिखा गया, हर एल्गोरिदम का शोध शैक्षणिक पत्रों और पाठ्यपुस्तकों के माध्यम से किया गया, और हर डिबगिंग सत्र में पारंपरिक तरीकों का उपयोग किया गया जैसे प्रिंट स्टेटमेंट, डिबगर्स, और विधिपूर्वक परीक्षण। जब मैं किसी समन्वय परिवर्तन या पीआईडी ट्यूनिंग समस्या पर अटका, तो मैं बस एक एआई सहायक से अवधारणा को समझाने या समस्या को डिबग करने में मदद नहीं मांग सकता था।

इसने विकास प्रक्रिया को काफी अधिक चुनौतीपूर्ण बना दिया लेकिन साथ ही अधिक शैक्षिक भी। मुझे:

सब कुछ मैन्युअल रूप से शोध करना पड़ा: पीआईडी नियंत्रण सिद्धांत को समझने का मतलब था पाठ्यपुस्तकों और शैक्षणिक पत्रों को पढ़ना। समन्वय परिवर्तन को समझने के लिए मुझे हाथ से गणित करना पड़ा। हर अवधारणा को कार्यान्वयन से पहले पूरी तरह से समझना आवश्यक था।

एआई सहायता के बिना डिबग करना पड़ा: जब रोबोट अप्रत्याशित दिशाओं में चले या लक्ष्यों के चारों ओर दोलन करें, तो मुझे विधिपूर्वक तर्क के माध्यम से ट्रेस करना पड़ा, डिबग आउटपुट जोड़ना पड़ा, और एक-एक करके परिकल्पनाओं का परीक्षण करना पड़ा। संभावित मुद्दों का सुझाव देने या त्रुटि पैटर्न को व्याख्या करने के लिए कोई एआई नहीं था।

प्रथम सिद्धांतों से सीखना पड़ा: “मैं रोबोटिक्स के लिए पायथन में बहु-प्रसंस्करण को कैसे लागू करूं?” पूछने की क्षमता के बिना, मुझे अंतर्निहित अवधारणाओं को गहराई से समझना पड़ा। इसने मुझे समवर्ती प्रोग्रामिंग, नियंत्रण प्रणालियों, और कंप्यूटर दृष्टि में एक ठोस आधार बनाने के लिए मजबूर किया।

डॉक्यूमेंटेशन महत्वपूर्ण था: चूंकि मैं बाद में कोड को समझाने के लिए एआई पर निर्भर नहीं रह सकता था, मुझे अत्यधिक स्पष्ट दस्तावेज़ और टिप्पणियाँ लिखनी पड़ीं। यह अनुशासन दूसरों को ज्ञान स्थानांतरित करते समय अमूल्य साबित हुआ।

पीछे मुड़कर देखें, जबकि आधुनिक एआई उपकरण विकास के कई पहलुओं को तेज कर सकते थे, उनके बिना काम करने ने मुझे गहरे समस्या-समाधान कौशल और अंतर्निहित प्रणालियों की अधिक गहन समझ विकसित करने के लिए मजबूर किया। यह सोचना दिलचस्प है कि आज के विकास उपकरणों के साथ यह परियोजना कितनी अलग हो सकती थी।

छोड़ने का कठिन निर्णय

जितना मुझे एचसीआर प्रयोगशाला में काम करना पसंद था, 2021 के अंत तक मुझे एक कठिन निर्णय का सामना करना पड़ा जो कई छात्रों का सामना करना पड़ता है: कई अवसरों और जिम्मेदारियों के बीच संतुलन बनाना। मैं एक ही समय में eBay में एक सॉफ़्टवेयर इंजीनियर के रूप में पूर्णकालिक काम कर रहा था, माइन में अपने कंप्यूटर विज्ञान की डिग्री पूरी कर रहा था, और एचसीआर प्रयोगशाला में अनुसंधान में योगदान दे रहा था।

eBay का अवसर महत्वपूर्ण था; यह मेरी पहली प्रमुख सॉफ़्टवेयर इंजीनियरिंग भूमिका थी, इसने अमूल्य उद्योग अनुभव प्रदान किया, और मुझे एक ठोस आय प्रदान की। हालाँकि, पूर्णकालिक काम बनाए रखने, अपनी डिग्री पूरी करने, और अनुसंधान में सार्थक योगदान देने की कोशिश करना बस अस्थिर था। कुछ तो छोड़ना था।

जब मैंने डॉ. झांग से संभावित रूप से अपने पाठ्यक्रम के बोझ को कम करने के बारे में बात की ताकि मैं प्रयोगशाला के काम पर अधिक ध्यान केंद्रित कर सकूं, तो उन्होंने इसके खिलाफ दृढ़ता से सलाह दी। उनका तर्क सही था: अपनी डिग्री पूरी करना प्राथमिकता होनी चाहिए, और eBay में उद्योग का अनुभव मेरे करियर विकास के लिए मूल्यवान होगा। उन्हें लगा कि अनुसंधान पर ध्यान केंद्रित करने के लिए कक्षाएँ छोड़ना, जबकि लुभावना था, शायद सबसे अच्छा दीर्घकालिक निर्णय नहीं हो सकता।

तो सितंबर 2021 में, प्रयोगशाला में लगभग 8 महीनों के गहन काम के बाद, मैंने अपने शोध सहायक की भूमिका से पीछे हटने का कठिन निर्णय लिया ताकि मैं अपनी डिग्री और eBay में अपने काम को पूरा करने पर ध्यान केंद्रित कर सकूं। यह उस समय में मुझे लेने वाले कठिन पेशेवर निर्णयों में से एक था।

आधिकारिक रूप से प्रयोगशाला छोड़ने के बाद भी, मैंने जब भी किसी को मेरी बनाई प्रणालियों के साथ मदद की आवश्यकता होती, तब समर्थन प्रदान करना जारी रखा। मैंने आवश्यकतानुसार दस्तावेज़ अपडेट किए, डिबगिंग के बारे में प्रश्नों का उत्तर दिया, और दूर से समस्याओं को हल करने में मदद की। मैंने जो संबंध बनाए थे और परियोजना की सफलता में जो निवेश किया था, वह केवल इसलिए नहीं गायब हुआ क्योंकि मैं अब आधिकारिक रूप से टीम का हिस्सा नहीं था।

विचार और पीछे मुड़कर देखना

अब, 2025 में, चार साल बाद, मैं उस समय पर जटिल भावनाओं के साथ विचार कर रहा हूँ। मेरा करियर पथ मुझे वेब विकास और एआई/एमएल इंजीनियरिंग में गहराई से ले गया, जो क्षेत्र बेहद संतोषजनक रहे हैं और विकास और प्रभाव के लिए tremendous अवसर प्रदान किए हैं।

फिर भी, मेरे अंदर एक हिस्सा है जो “क्या होगा” के बारे में सोचता है। रोबोटिक्स मेरी सच्ची जुनून थी, और ईमानदारी से अभी भी है। भौतिक प्रणालियों के साथ काम करने, अपने कोड को वास्तविक दुनिया की गति और व्यवहार में बदलते हुए देखने में कुछ ऐसा है, जो वेब विकास और यहां तक कि एआई कार्य भी पूरी तरह से दोहराने में असमर्थ हैं।

मैं कभी-कभी सोचता हूँ कि अगर मैंने एक अलग रास्ता चुना होता तो क्या होता। अगर मैंने रोबोटिक्स अनुसंधान में रहने का कोई तरीका खोजा होता? अगर मैंने अपनी स्नातक डिग्री पूरी करने के तुरंत बाद स्नातकोत्तर विद्यालय का पीछा किया होता? अगर मैंने उद्योग के अनुभव पर प्रयोगशाला के काम को प्राथमिकता देने का निर्णय लिया होता?

लेकिन मैं यह भी पहचानता हूँ कि हर रास्ते के अपने व्यापार-निष्कर्ष होते हैं। मैंने जो कौशल वेब विकास और एआई में विकसित किए हैं, वे बेहद मूल्यवान रहे हैं। उद्योग का अनुभव ने मुझे बड़े पैमाने पर सॉफ़्टवेयर इंजीनियरिंग, उपयोगकर्ता अनुभव डिज़ाइन, और उन व्यावहारिक चुनौतियों के बारे में सिखाया है जो उत्पादों का निर्माण करते समय सामने आती हैं जो लाखों लोग उपयोग करते हैं। इन अनुभवों ने मुझे समग्र रूप से एक बेहतर इंजीनियर बना दिया है।

मैंने एचसीआर प्रयोगशाला में जो काम किया, वह आज भी यह प्रभावित करता है कि मैं समस्याओं का सामना कैसे करता हूँ। पीआईडी नियंत्रण प्रणालियों के लिए आवश्यक प्रणालीगत सोच सॉफ़्टवेयर प्रणालियों में फीडबैक लूप डिज़ाइन करने में दिखाई देती है। मैंने जो दस्तावेज़ीकरण और ज्ञान संरक्षण कौशल विकसित किए हैं, वे तब से हर भूमिका में अमूल्य रहे हैं। मेंटरिंग और सिखाने का अनुभव ने यह आकार दिया है कि मैं जूनियर डेवलपर्स के साथ कैसे काम करता हूँ और टीम ज्ञान साझा करने में योगदान देता हूँ।

सबसे महत्वपूर्ण बात यह है कि इस अनुभव ने मुझे सिखाया कि मैं उन चुनौतीपूर्ण तकनीकी समस्याओं पर काम करते समय फलता-फूलता हूँ जिनका वास्तविक दुनिया पर प्रभाव होता है। चाहे वह रोबोट आंदोलन एल्गोरिदम को अनुकूलित करना हो या ऐसे एआई सिस्टम बनाना हो जो उपयोगकर्ताओं को उनके लक्ष्यों को प्राप्त करने में मदद करें, संतोष कठिन समस्याओं को हल करने से आता है जो मायने रखती हैं।

स्थायी प्रभाव

एचसीआर प्रयोगशाला के अनुभव पर पीछे मुड़कर देखता हूँ, तो मैं इस बात से प्रभावित हूँ कि मैंने अपेक्षाकृत कम समय में कितना कुछ हासिल किया। मैंने जो प्रणालियाँ बनाई, उन्होंने ट्राइटन प्लेटफ़ॉर्म के संचालन के तरीके को मौलिक रूप से बदल दिया, और उनमें से कई सुधार आज भी उपयोग किए जा रहे हैं। मैंने जो दस्तावेज़ीकरण भंडार बनाया, वह पूरे परियोजना के लिए ज्ञान का आधार बन गया। मैंने जो मेंटरशिप संबंध बनाए, उनका उन लोगों पर स्थायी प्रभाव पड़ा जिनके साथ मैंने काम किया।

लेकिन शायद सबसे महत्वपूर्ण बात यह है कि इस अनुभव ने मुझे दिखाया कि जब मैं उन समस्याओं पर काम करता हूँ जिनके प्रति मैं वास्तव में जुनूनी हूँ, तो मैं क्या करने में सक्षम हूँ। उन आठ महीनों में, मैंने:

- प्लेटफ़ॉर्म को सीमित करने वाले रोबोट आंदोलन नियंत्रण प्रणाली में सुधार किया

- शून्य से एक बहु-रोबोट समन्वय प्रणाली बनाई

- कंप्यूटर दृष्टि और सेंसर फ्यूजन क्षमताओं का एकीकरण किया

- एक व्यापक दस्तावेज़ीकरण और ज्ञान प्रबंधन प्रणाली बनाई

- कई लोगों को मेंटर किया और ज्ञान हस्तांतरण में मदद की

- स्वायत्त वाहनों में पीएचडी स्तर के शोध का समर्थन किया

हालांकि यह केवल तकनीकी उपलब्धियों के बारे में नहीं था, जो मेरे लिए महत्वपूर्ण थीं। यह इस बारे में सीखने के बारे में था कि निरंतरता और प्रणालीगत सोच के साथ, आप एक अंडरग्रेजुएट छात्र के रूप में भी उपयोगी योगदान कर सकते हैं।

भविष्य और रोबोटिक्स

हालांकि मेरा करियर मुझे अन्य दिशाओं में ले गया है, लेकिन रोबोटिक्स के प्रति मेरी रुचि कम नहीं हुई है। मैं अभी भी इस क्षेत्र में विकास का पालन करता हूं, मैं रोबोट सीखने और स्वायत्त प्रणालियों में प्रगति के बारे में उत्साहित हूं, और मैं कभी-कभी अपने खाली समय में व्यक्तिगत रोबोटिक्स परियोजनाओं पर काम करता हूं।

कौन जानता है भविष्य में क्या है? मैं जो कौशल एआई और मशीन लर्निंग में विकसित कर रहा हूं, वे रोबोटिक्स के लिए लगातार प्रासंगिक होते जा रहे हैं। मैंने जो उद्योग अनुभव प्राप्त किया है, उसने मुझे मजबूत, स्केलेबल सिस्टम बनाने का तरीका सिखाया है। शायद एक भविष्य है जहां मेरे अनुभव के ये विभिन्न धागे अप्रत्याशित तरीकों से एक साथ आते हैं।

फिलहाल, मैं HCR लैब में बिताए समय और इसके द्वारा प्रदान किए गए अनुभवों के लिए आभारी हूं। यह एक प्रारंभिक अवधि थी जिसने मेरी तकनीकी क्षमताओं और यह समझने में आकार दिया कि मुझे किस प्रकार का काम सबसे संतोषजनक लगता है। हालांकि कभी-कभी मुझे इसकी याद आती है, मैं जानता हूं कि मैंने जो पाठ सीखे और जो दृष्टिकोण विकसित किए, वे जो कुछ भी मैं करता हूं, उसे प्रभावित करते रहते हैं।

ट्राइटन रोबोट अभी भी वहां हैं, शोधकर्ताओं की सेवा कर रहे हैं, महत्वपूर्ण कार्य को सक्षम कर रहे हैं। और यह काफी अद्भुत है।