Algorithme de Pose Mobile

Notre présentation finale de décembre 2020

À Propos du Projet

En tant que projet final pour le cours Introduction à l’Apprentissage Automatique (CSCI470) de l’automne 2020 à l’École des Mines du Colorado, notre équipe, composée d’Andrew Darling, Eric Hayes et moi-même (Mehmet), a implémenté l’algorithme “Pose Mobile”.

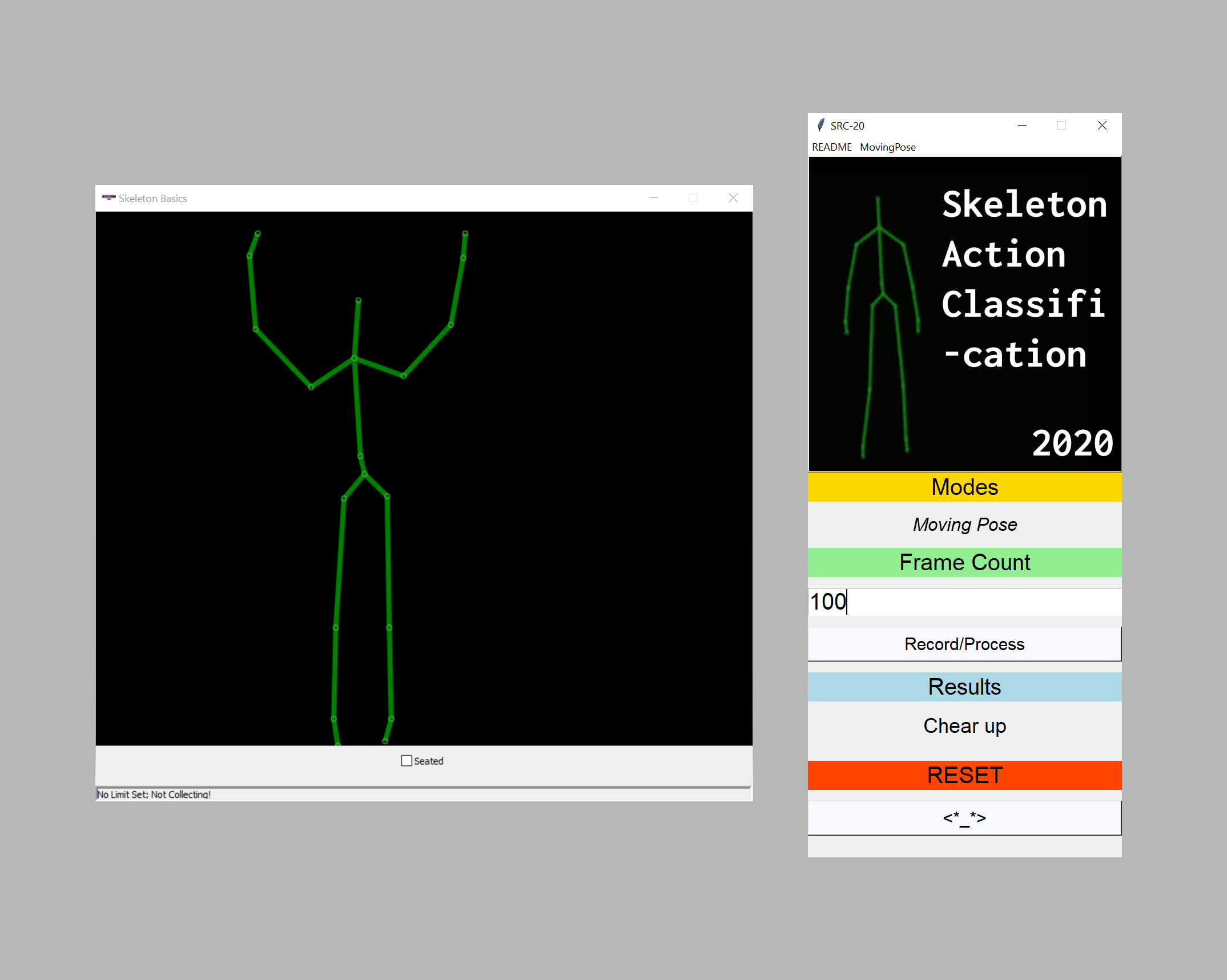

L’objectif était de prendre un ensemble de données squelettiques capturé par un capteur de profondeur et de classifier les actions humaines. Nous avons non seulement implémenté l’algorithme de base, mais également développé une interface utilisateur simple pour démontrer ses capacités.

L’algorithme de Pose Mobile, proposé à l’origine par Mihai Zanfir, Marius Leordeanu et Cristian Sminchisescu, est une méthode puissante pour reconnaître et comprendre rapidement et avec précision les actions humaines à partir de données squelettiques 3D.

Le Document

Notre implémentation est basée sur le document The Moving Pose: An Efficient 3D Kinematics Descriptor for Low-Latency Action Recognition and Detection (PDF) par Mihai Zanfir, Marius Leordeanu, et Cristian Sminchisescu.

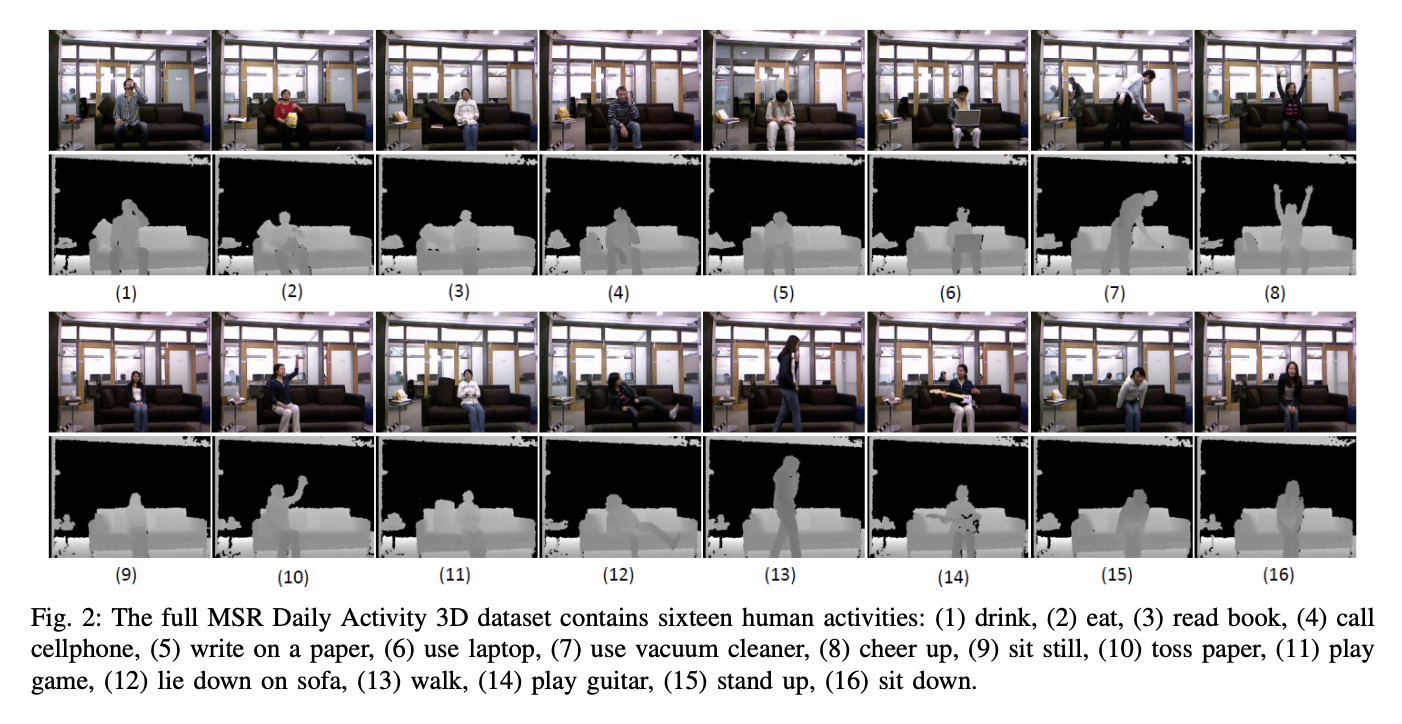

Ensemble de Données

Notre modèle a été entraîné et testé sur l’Ensemble de Données 3D MSR DailyActivity. Nous nous sommes concentrés sur les actions suivantes de l’ensemble de données :

Aperçu de l’UI

Nous avons construit une interface graphique simple pour visualiser les performances de l’algorithme en temps réel. Pour plus de détails sur l’interface graphique et le matériel utilisé, veuillez consulter le fichier README.md dans le répertoire /movingpose/gui/ du dépôt du projet.